OpenAI的瘋狂數據中心,芯片猜想

《The Information》在上周五復活節假期开始時報道了有關微軟和OpenAI合作的Stargate(星際之門)的報道,該報告與超以太網聯盟(微軟是其創始成員)設定的100 萬個互連端點的可擴展性未來以太網目標一致。

星際之門系統也從此引起了人們的議論。 Altman 似乎無法決定 OpenAI 是否應該完全依賴微軟,但誰能責怪他呢?這就是爲什么還有傳言稱OpenAI 正在設計自己的用於人工智能訓練和推理的芯片,以及關於Altman試圖帶頭投資 7 萬億美元芯片制造但隨後又放棄的令人憤慨的評論。

你不能責怪Altman亂扔了他正在盯着的大數字。訓練人工智能模型非常昂貴,並且運行推理——主要是生成tokern——也不便宜。正如 Nvidia 聯合創始人兼首席執行官黃仁勳最近在 GTC 2024 會議上的主題演講中指出的那樣——他們是不可持續的昂貴。這就是 Microsoft、Amazon Web Services、Google 和 Meta Platform 已經創建或正在創建自己的 CPU 和 XPU 的原因。

隨着參數數量的增加以及數據從文本格式轉變爲其他格式,如果目前的趨勢持續下去並且鐵可以擴展,那么LLM只會變得越來越大——在未來幾年內將增長 100 倍到 1,000 倍。

因此,我們聽到有關《星際之門》的討論,這表明人工智能訓練的上層毫無疑問是富人的遊戲。

根據您在最初的《星際之門》傳聞後的報告中所讀到的內容,《星際之門》是一個項目的第五階段,該項目將耗資 1000 億至 1150 億美元,星際之門將於 2028 年交付,並在 2030 年及以後運營。微軟目前顯然正處於擴建的第三階段。據推測,這些資金數字涵蓋了機器的所有五個階段,目前尚不清楚該數字是否涵蓋了數據中心、內部機械以及電力成本。微軟和 OpenAI 可能不會採取太多行動來解決這個問題。

目前還沒有討論 Stargate 系統將基於什么技術,但我們認爲它不會基於 Nvidia GPU 和互連。它將基於未來幾代的 Cobalt Arm 服務器處理器和 Maia XPU,以太網可擴展到單台機器中數十萬到 100 萬個 XPU。

我們還認爲,微軟收購了 DPU 制造商 Fungible 來創建可擴展的以太網網絡,並且可能讓Juniper Networks 和 Fungible 的創始人Pradeep Sindhu創建匹配的以太網交換機 ASIC,以便微軟可以控制其整個硬件堆棧。

當然,這只是一個猜想。

無論 Microsoft 使用哪種以太網網絡,我們都相當確定在某個時候 100 萬個端點是目標,而我們也相當確定 InfiniBand 不是答案。

我們還認爲,假設的這款 XPU 將與未來的 Nvidia X100/X200 GPU 或其後繼產品(我們不知道其名稱)一樣強大是不太可能的。微軟和 OpenAI 更有可能嘗試大規模擴展更便宜的設備網絡,並從根本上降低人工智能訓練和推理的總體成本。

他們的商業模式取決於這種情況的發生。

而且我們還可以合理地假設,在某個時候 Nvidia 將不得不創建一個擠滿矩陣數學單元的 XPU,並舍棄讓該公司在數據中心計算領域起步的矢量和着色器單元。如果微軟爲 OpenAI 打造了一個更好的mousetrap,那么 Nvidia 將不得不效仿。

Stargate 肯定代表了人工智能支出的階梯函數,也許還有兩個階梯函數,具體取決於你想要如何解釋數據。

在數據中心預算方面,微軟迄今爲止公开表示的全部內容是,它將在 2024 年和 2025 年在數據中心上花費超過 100 億美元,我們推測其中大部分支出用於支付 AI 服務器的成本。那些 1000 億美元或 1150 億美元的數字太模糊,無法代表任何具體內容,因此目前這只是一些大話。我們要提醒您的是,在過去的十年中,微軟至少保留了 1000 億美元的現金和等價物,並在 2023 年 9 月的季度達到了接近 1440 億美元的峰值。截至 2023 日歷年(微軟 2024 財年第二季度),該數字下降至 810 億美元。

因此,微軟現在沒有足夠的資金來一次性完成 Stargate 項目,但其軟件和雲業務在過去 12 個月的銷售額總計達到 825 億美元,而銷售額約爲 2276 億美元。未來六年,如果軟件和雲業務保持原樣,微軟將帶來 1.37 萬億美元的收入,淨利潤約爲 5000 億美元。它可以承擔星際之門的努力。微軟也有能力購买 OpenAI,然後就可以結束它了。

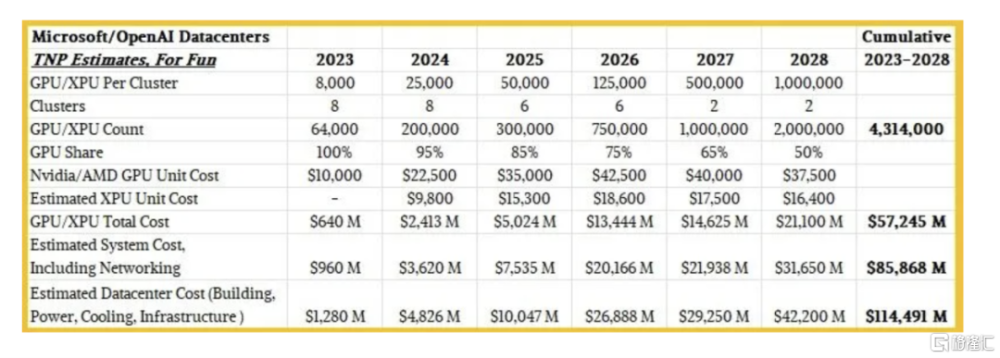

不管怎樣,我們爲微軟可能已經構建的集群以及未來可能爲 OpenAI 構建的集群制定了預算,展示了它們的組成和規模如何隨着時間的推移而變化。看一下:

我們認爲,隨着時間的推移,分配給 OpenAI 的 AI 集群數量將會減少,而這些集群的規模將會增加。

我們還認爲 OpenAI 集群中 GPU 的份額將會下降,而 XPU 的份額(很可能在 Maia 系列中,但也可能使用 OpenAI 設計)將會上升。隨着時間的推移,自研XPU 的數量將與 GPU 的數量相匹配,我們進一步估計這些 XPU 的成本將不到數據中心 GPU 成本的一半。此外,我們認爲從 InfiniBand 轉向以太網也將降低成本,特別是如果微軟使用自主研發的以太網 ASIC 和內置人工智能功能和集體操作功能的自主研發的 NIC。 (就像 Nvidia 的 InfiniBand 的 SHARP 功能一樣。)

我們還強制採用支出模型,以便在 2028 年有兩個擁有 100 萬個端點的集群——一個由 GPU 組成,一個由自研 XPU 組成,或者兩個集群各佔一半。我們想要估計未來的集群性能,但這很難做到。每年可能會有更多的 XPU 獲得適度的性能提升,但性價比卻要高得多。

需要記住的是,微軟可以保留當前一代的 GPU 或 XPU 供 OpenAI 內部使用(因此也是其自己的),並在未來許多年內向用戶出售N-1和N-2代,很可能會獲得很多收益其投資誘餌再次回到 OpenAI 上。因此,這些投資本身並不是沉沒成本。這更像是一個汽車經銷商駕駛着一大堆掛有經銷商牌照的不同汽車,但在出售它們之前並沒有將裏程數提高得太高。

問題是:微軟會繼續在 OpenAI 上投入巨資,以便扭虧爲盈並租用這些產能嗎,還是會停止在 OpenAI 上花費 1000 億美元(兩個月前該公司的估值爲 800 億美元)?另外還要花費 1100 億美元左右的基礎設施建設,以完全控制其人工智能堆棧。

即使對於微軟來說,這些數字也是相當大的。但是,正如我們所說,如果你看看 2024 年至 2028 年,微軟可能有大約 5000 億美元的淨利潤可供使用。很少有其他公司這樣做。

微軟從一個 BASIC 編譯器和一個從第三方拼湊出來的垃圾 DOS 操作系統开始,爲一個不理解它的絕望的藍色巨人做裝飾,這簡直是在放棄糖果店。

也許這也是奧特曼的噩夢。但考慮到將人工智能推向新的高度需要巨額資金,現在可能爲時已晚。

標題:OpenAI的瘋狂數據中心,芯片猜想

地址:https://www.iknowplus.com/post/94855.html