DeepSeek發布新技術論文,梁文鋒親自掛帥,長文本推理能力飆升

2月18日,DeepSeek團隊發布了一項具有裏程碑意義的技術成果——原生稀疏注意力機制(Native Sparse Attention,NSA)。

這一創新技術專爲長文本訓練與推理設計,通過算法優化與硬件對齊,顯著提升了大語言模型在長上下文任務中的效率和性能。

DeepSeek創始人梁文鋒不僅親自參與了這項研究,還親自提交了相關論文,其他研究人員來自DeepSeek、北大和華盛頓大學,其中第一作者Jingyang Yuan(袁景陽)是在DeepSeek實習期間完成的這項研究。

從時間上看,梁文鋒是在周日16號提交的論文,然後在第二天,也就是昨天出席了民營企業座談會。

革命性NSA注意力機制問世

根據最新發布的論文,NSA的核心亮點可以概括爲以下兩點:

1、動態分層稀疏策略:NSA採用了一種動態分層的稀疏策略,結合了粗粒度的Token壓縮和細粒度的Token選擇。這種策略既提升了效率,也保留了模型對全局長上下文的感知能力和局部精確性。

2、兩大關鍵創新:算術強度平衡的算法設計與硬件優化,NSA通過精巧的算法設計,並針對現代硬件進行了實現優化,顯著提升了計算速度;可訓練的稀疏注意力,NSA支持端到端訓練,減少了預訓練計算成本,同時保持模型性能。

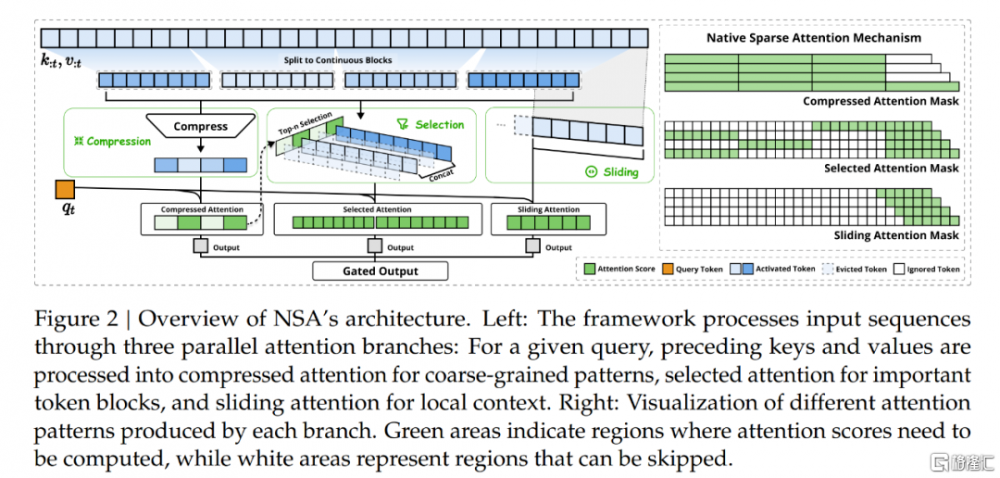

具體來看,NSA的核心在於動態分層稀疏策略,結合了粗粒度的Token壓縮和細粒度的Token選擇。這種策略不僅保留了全局上下文的感知能力,還兼顧了局部信息的精確性。

具體而言,NSA通過三種並行的注意力分支處理輸入序列:壓縮注意力(Compressed Attention)、選擇注意力(Selected Attention)和滑動窗口注意力(Sliding Window Attention)。

壓縮注意力負責捕獲全局信息,選擇注意力專注於關鍵Token塊,而滑動窗口注意力則處理局部上下文信息。三個分支的輸出通過門控機制聚合,從而實現高效的長文本建模。

此外,NSA還引入了算術強度平衡的設計,針對現代硬件進行優化,顯著提升了計算速度。通過端到端的可訓練性,NSA減少了預訓練計算量,同時保持了模型性能。

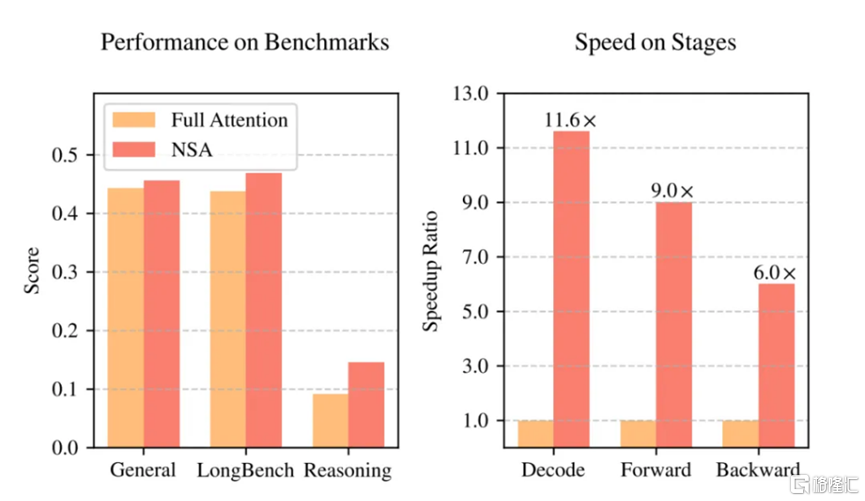

這些創新使得NSA在長上下文任務中表現出色,特別是在處理64k長度的序列時,解碼、前向傳播和反向傳播的速度提升最高可達11.6倍。

有網友說這就像給Transformer裝上了"曲率引擎°"。確實,這提升太離譜了!就連很多大佬都忍不住要感嘆:這是把傳統注意力機制按在地上擦啊!

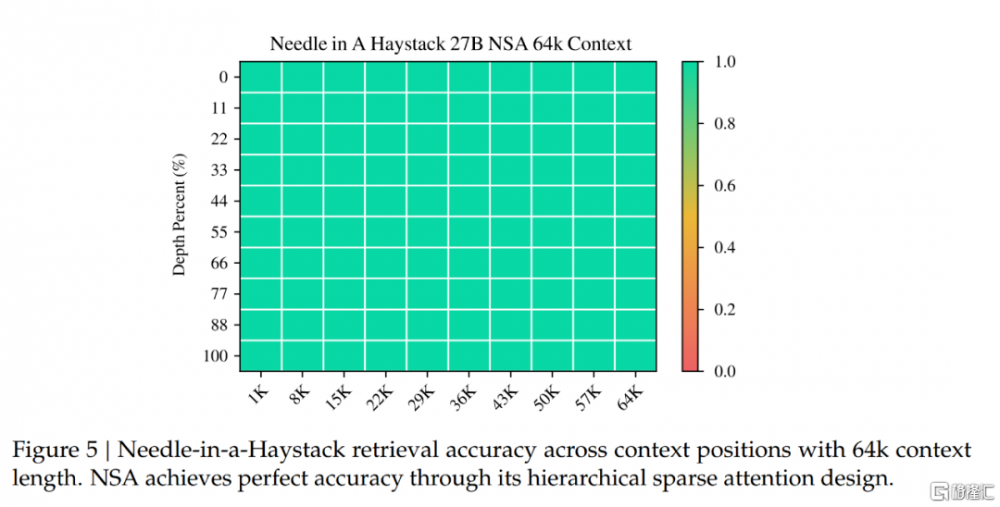

實驗結果顯示,NSA在多個基准測試中均展現出卓越的性能。在通用基准測試、長文本任務和指令推理方面,使用NSA預訓練的模型不僅性能超越了傳統的全注意力模型,還在長上下文任務中展現出顯著優勢。

在64k上下文的“大海撈針”測試中,NSA實現了完美的檢索准確率,證明了其在長序列處理中的高效性和准確性。

在硬件效率方面,NSA的表現同樣令人矚目。

在8卡A100計算集群上,NSA的前向傳播和反向傳播速度分別比全注意力快9倍和6倍。這種速度提升不僅源於硬件對齊的算法設計,還歸功於分塊內存訪問模式和精細的循環調度,最大限度地利用了Tensor Core的計算能力。

通過減少內存訪問量,NSA在長序列解碼時的效率優勢尤爲明顯,尤其是在處理128k上下文時,速度提升更爲顯著。

NSA的推出爲大語言模型在長文本處理領域的應用帶來了新的可能性。通過高效的長序列處理能力,模型可以直接處理整本書籍、代碼倉庫或多輪對話(如千輪客服場景),極大地擴展了大語言模型的應用邊界。Gemini 1.5 Pro已展示了長上下文的潛力,而NSA的引入將進一步降低此類模型的訓練與推理成本。

與此同時,NSA的硬件友好設計和訓推一體化特性使其在實際應用中更具優勢。

科技媒體指出,DeepSeek此次使用了Triton框架,而非英偉達專用庫,這或許暗示了其在模型研發階段已考慮適配更多類型的計算卡,爲未來的开源和廣泛應用奠定了基礎。

同日早些消息,馬斯克旗下XAI舉行Grok 3發布會,對此,很快也有對比分析指出,與DeepSeek的技術創新路徑形成鮮明對比的是,xAI選擇了對工程規模的極致追求。

Grok3使用了20萬塊GPU集群,而未來的Grok4更是計劃使用百萬塊GPU。這種“財大氣粗”的策略雖然在短期內實現了對之前SOTA模型的反超,但投入產出比並不理想。

相比之下,DeepSeek通過算法優化和硬件對齊,以更低的成本實現了更高的性能提升,展現了其在技術破局中的獨特優勢。

附論文鏈接:https://arxiv.org/abs/2502.11089

標題:DeepSeek發布新技術論文,梁文鋒親自掛帥,長文本推理能力飆升

地址:https://www.iknowplus.com/post/194441.html