OpenAI又爆了!首個視頻生成模型Sora驚豔亮相,視頻行業被顛覆?

下一波人工智能顛覆浪潮已經到來。

繼ChatGPT大語言模型之後,OpenAI又推出文生視頻大模型大模型——Sora。

過去的一年多,文本和圖片領域已先後被AI穩穩拿下,視頻領域雖也有進展但肉眼可見存在諸多不足。

然而,從現在开始,“有視頻有真相”可能也將成爲歷史。

OpenAI創始人兼CEO山姆·阿爾特曼在海外社交平台X上瘋狂刷屏,各種展示生成的視頻效果。網友們也炸了鍋,微博上有達人激動地寫道:“這生成質量和運鏡幅度直接把我看醒了……”

文字秒變視頻超逼真

據介紹,Sora可以直接輸出長達60秒的視頻,並且包含高度細致的背景、復雜的多角度鏡頭,以及富有情感的多個角色。

例如一個Prompt(大語言模型中的提示詞)的描述是:在東京街頭,一位時髦的女士穿梭在充滿溫暖霓虹燈光和動感城市標志的街道上。

在Sora生成的視頻裏,女士身着黑色皮衣、紅色裙子在霓虹街頭行走,不僅主體連貫穩定,還有多鏡頭,包括從大街景慢慢切入到對女士的臉部表情的特寫,以及潮溼的街道地面反射霓虹燈的光影效果。

Sora生成的視頻截圖,圖片來源:OpenAI官網

輸入 prompt:穿過東京郊區的火車窗外的倒影。

也可以來一段好萊塢大片質感的電影預告片:

這樣一部60秒一鏡到底的視頻,無疑都刷新了人們對於人工智能視頻創作能力的認知。在一衆AI創作視頻工具(Runway Gen 2、Pika)還都掙扎在4秒連貫性的邊緣,OpenAI直接支持60秒高清視頻的穩定輸出,已經達到了史詩級的紀錄。

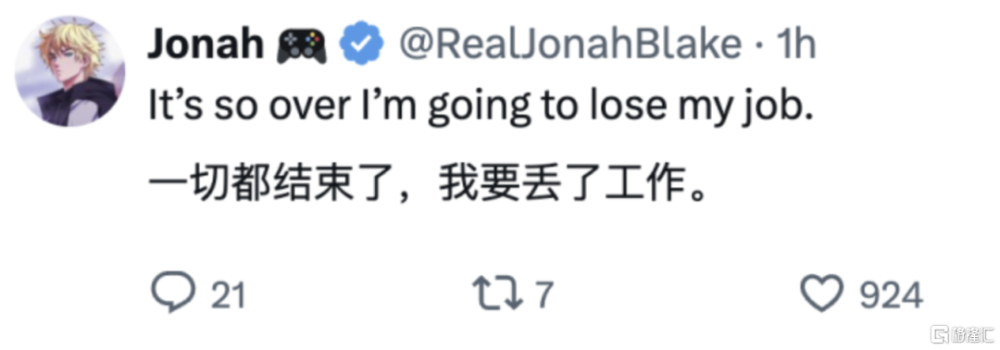

有些工程師這樣說道:“我要丟了工作......”

整體還不太完美

盡管 OpenAI 擁有最先進的技術,但它也承認該模型並不完美。它寫道:

“[Sora] 可能很難准確模擬復雜場景的物理原理,並且可能無法理解因果關系的具體實例。例如,一個人可能咬了一口餅幹,但之後,餅幹可能沒有該模型還可能會混淆提示的空間細節,例如混淆左右,並且可能難以准確描述隨着時間推移發生的事件,例如遵循特定的相機軌跡。

OpenAI 將 Sora 定位爲研究預覽,很少透露用於訓練模型的數據(缺少約10000 小時的“高質量”視頻),並且沒有讓 Sora 普遍可用。其理由是濫用的可能性;OpenAI 正確地指出,不良行爲者可能會以多種方式濫用像 Sora 這樣的模型。

OpenAI 表示,它正在與專家合作探索漏洞利用模型,並構建工具來檢測視頻是否由Sora生成。

該公司還表示,如果選擇將該模型構建到面向公衆的產品中,它將確保生成的輸出中包含來源元數據。

OpenAI 寫道:“我們將與世界各地的政策制定者、教育工作者和藝術家合作,了解他們的擔憂並確定這項新技術的積極用例。”

“盡管進行了廣泛的研究和測試,我們仍然無法預測人們使用我們的技術的所有有益方式,也無法預測人們濫用我們的技術的所有方式。這就是爲什么我們相信從現實世界的使用中學習是創造和發布越來越多的技術的關鍵組成部分。隨着時間的推移,人工智能系統會更加安全。”

標題:OpenAI又爆了!首個視頻生成模型Sora驚豔亮相,視頻行業被顛覆?

地址:https://www.iknowplus.com/post/81185.html