中金研究:AI端側落地加速,开啓實時互動新紀元

本周Open AI與谷歌分別發布新一代模型:GPT-4o和Gemini系列模型。本文將介紹兩大AI巨頭在大模型領域的進展,並圍繞硬件、操作系統、算力等方面進行探討。我們認爲,隨着AI在端側的逐漸落地,將帶動消費電子終端創新升級,並對雲端算力硬件系統尤其是推理側需求提出更高要求。

摘要

Gemini 1.5 Pro與GPT-4o有何異同?我們認爲,GPT-4o是端到端模型的創新,帶來人機交互方式新突破;谷歌Gemini性能升級,AI能力廣泛接入旗下生態。對比來看,兩者都是原生多模態大模型,有望引發行業的效仿熱情,原生多模態或成爲未來發展趨勢;但差異點在於,Gemini上下文窗口更大,且定價更具吸引力;GPT-4o模型性能更強,且更強調實際應用場景中的人機交互創新。

AI端側落地帶來消費電子終端人機交互方式變革,關注操作系統升級及應用前景。在硬件側,我們認爲,此次兩大模型發布從四個方面加快了AI落地端側的進度:1)多模態交互方式革新;2)AI語音助手擬人化;3) AI功能在移動設備的應用前景;4)商業化前景。雖然當前大模型仍以雲端算力調用爲主,但從當前各家在模型參數壓縮的努力,結合端側商業變現的前景,未來部分算力下沉到端側將成爲必由之路,對應消費電子終端在硬件層面也將迎來創新升級。在操作系統及應用側,語音助手擬人化程度提升,一方面使AI agent成爲可能,另一方面未來交互方式變化或帶來流量入口變化,深刻影響生態格局。

雲端算力硬件:GPT-4o部分功能的免費开放,Gemini能力的提升或對單位算力成本下探提出要求,AI infra面臨大幅優化。我們看到,當下行業對算力硬件性能、成本的衡量以訓練導向逐漸轉爲推理導向。除了芯片端、網絡硬件端(如光模塊)持續升級外,系統工程能力也正不斷強化:爲獲得更低的硬件利用率,降低推理成本,優化顯存、實施算子融合/算子實現優化、低精度(量化)推理、分布式推理均是主流實現方式。我們認爲算力硬件市場有望隨應用落地步入以價換量時代,市場規模或將持續增長。

風險

AI算法技術及應用落地進展不及預期,AI變現模式不確定,消費電子智能終端需求低迷。

正文

GPT-4o VS谷歌Gemini:大模型迭代到哪了?

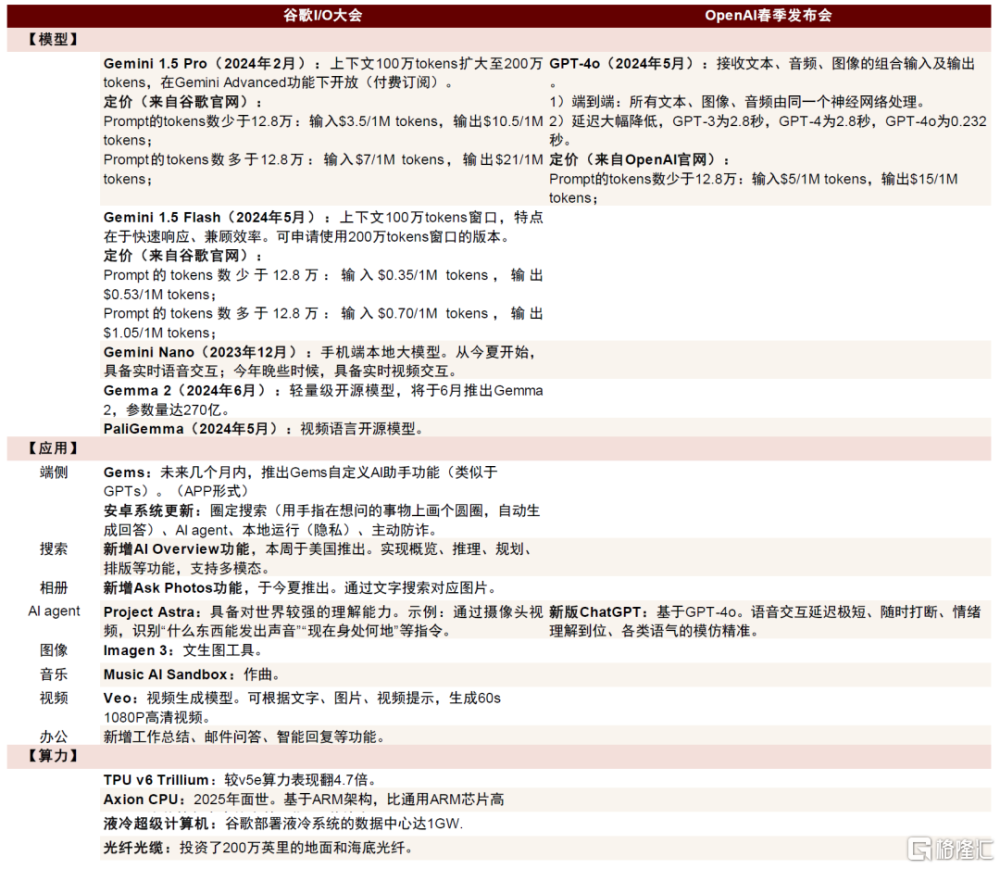

圖表1:谷歌I/O大會與OpenAI春季發布會內容一覽

資料來源:谷歌2024年I/O大會,OpenAI春季發布會,中金公司研究部

Open AI:GPT-4o是端到端模型的創新,帶來人機交互方式新突破

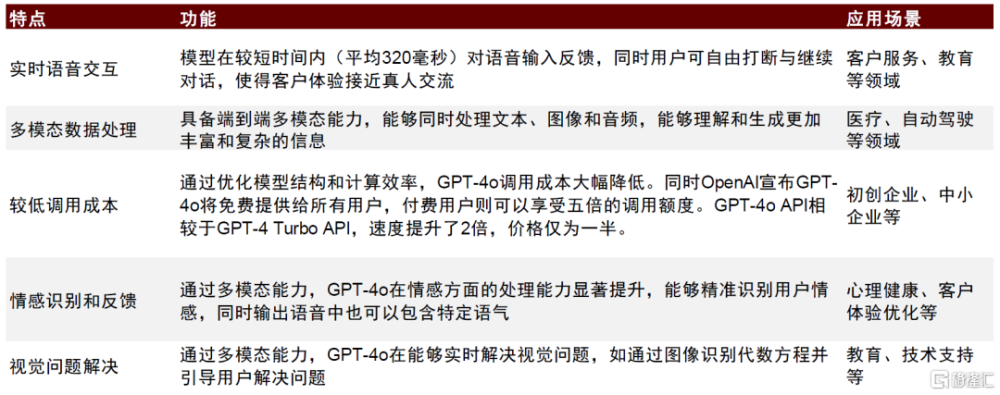

5月13日,OpenAI在春季發布會上推出新一代旗艦模型GPT-4o(o爲omni,即包羅萬象之意)。GPT-4o在GPT-4的基礎上新增語言處理能力,可接受文本、音頻和圖像的任意組合作爲輸入,並生成文本、音頻和圖像的任意組合輸出;同時在時延、人類語氣模擬、表達等方面更加接近人類表達,是邁向更自然人機交互的一步。

模型側:解鎖更多實時應用場景

低延遲、迅速響應提升語音助手擬人化能力。在GPT-4o之前,使用語音模型對話的平均延遲時間爲2.8秒(GPT-3.5)和5.4秒(GPT-4)。得益於從三個模型到一個端到端模型的轉變,GPT-4o能在232毫秒內對音頻輸入做出反應,平均反應時間爲320毫秒,這與人類在對話中的反應時間相近,提升了用戶體驗。

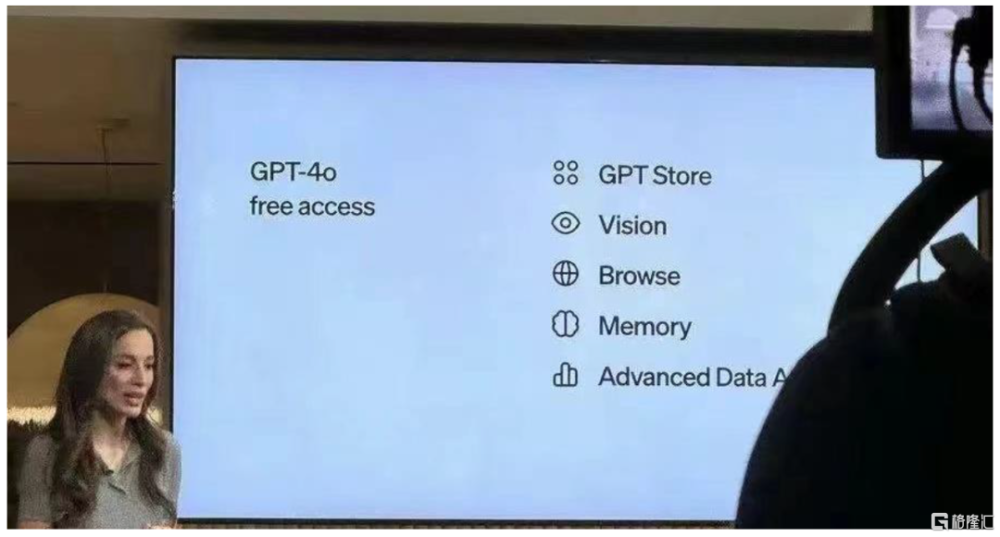

免費开放、API調用性價比提升,有望打开商業化空間。OpenAI在發布會上宣布GPT-4o將免費提供給所有用戶[1],付費用戶則可以享受五倍的調用額度。GPT-4o API相較於GPT-4 Turbo API,速度提升了2倍,價格僅爲一半。

應用側:語音助手打开AI實時互動場景空間

此外,GPT-4o發布會也將重點放在了AI與實際應用場景的結合上。在大會上,Open AI展示了衆多GPT-4o以語音助手的方式與使用者進行多模態交互的實際場景,包括執行語音搜索、圖像識別、情感反饋識別等。這些實際場景的展示,使市場看到了未來AI潛在應用落地場景的廣闊空間。

圖表2:GPT-4o功能特點及應用場景情況

資料來源:OpenAI官網,上海开理悟智科技有限公司官網,中金公司研究部

谷歌:Gemini性能升級,AI能力廣泛接入旗下生態

2024年5月14日,谷歌召开2024年I/O大會,並發布了一系列大模型產品以及AI應用。我們看到,OpenAI和谷歌雙方前後分別召开新品發布會,大有相互較量之勢,例如Gemini 1.5 Pro之於GPT-4o、Project Astra之於ChatGPT-4o、Gems之於GPTs、Veo之於Sora等,體現出谷歌正加速縮小與OpenAI在AI大模型方面之間的差距。此外,我們認爲AI Overview、Ask Photos、AI+Workspace等功能的推出,也反映出谷歌正積極憑借自身的產業、生態優勢,推動AI與應用的融合。

模型側:深化大模型在端側的部署

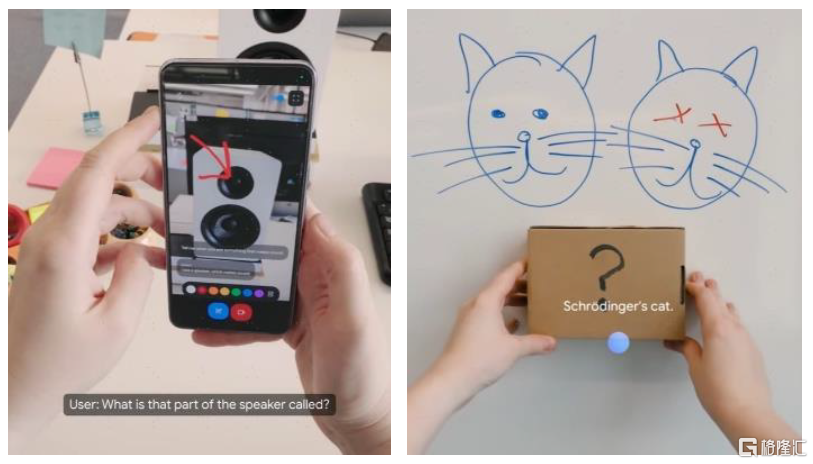

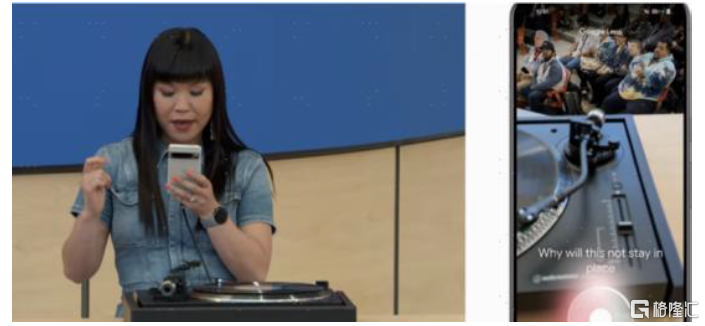

Project Astra對標ChatGPT-4o,打造更流暢、更豐富的人機交互體驗。Project Astra基於谷歌Gemini大模型,能夠同時處理視覺、語音等多模態信號,並展現出較強的理解、記憶和即時響應能力。我們觀察到,演示中Project Astra至少在智能手機(Google Pixel)以及智能眼鏡(prototype glasses)兩個硬件設備上運行,我們認爲AI大模型正加速向各類智能終端側部署應用。

圖表3:Project Astra演示demo

注:左圖爲智能手機端運行,右圖爲智能眼鏡端運行;資料來源:谷歌2024年I/O大會,中金公司研究部

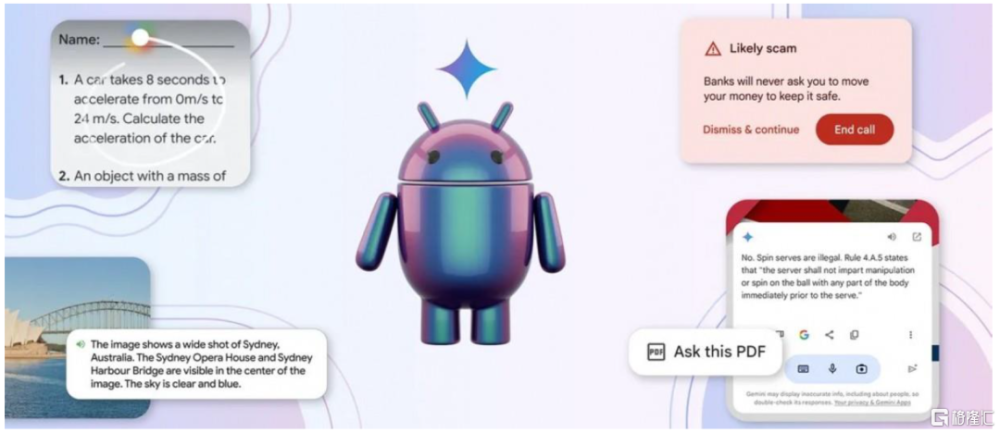

端側應用功能迎來升級。1)Gemini Nano:目前運行於端側的Nano模型僅用於文本模態,谷歌宣布將於今夏實現實時語音交互功能[2],並在今年晚些時候上线視頻交互功能,多模態功能趨於完善。2)Gems:與OpenAI的GPTs類似,Gems能夠定制具備特定特徵的AI助理,爲使用者提供健身、陪伴、烹飪、編程、寫作等任務的個性化協助。3)安卓系統升級:谷歌宣布新增三項AI功能:Circle to search、AI agent、模型本地化部署,在保障隱私安全的情況下,提升安卓系統的智能化水平。

應用側:搜索、相冊、音視頻、辦公,谷歌生態廣泛AI化

谷歌憑借本身在生態上的優勢,積極推動AI與應用的融合。1)搜索:AI Overview能夠在搜索中自動總結全網內容,實現概覽、推理、規劃、排版等功能。2)相冊:Ask Photos通過自然語言實現對特定相冊照片的搜索。3)辦公:在AI Workspace中新增工作總結、郵件問答、智能回復等功能,將AIGC賦能企業自動化,提升辦公生產效率。4)多模態:谷歌推出Imagen 3、Music AI Sandbox、Veo等大模型,分別對應圖像、音樂、視頻生成;其中Veo模型能夠根據多種模態信息的提示,生成時長超1分鐘的1080P高清視頻,與OpenAI Sora的差距進一步縮小。谷歌當前產業覆蓋智能終端、互聯網、企業、醫療、無人駕駛等多個產業,作爲一家生態布局相當廣泛的科技大廠,我們認爲谷歌在應用側落地具有先天的優勢。隨着大模型技術的不斷成熟,我們預計谷歌有望加速應用落地。

對比:Gemini 1.5 Pro與GPT-4o有何異同?

相同點:兩者都是原生多模態大模型,指引技術發展趨勢

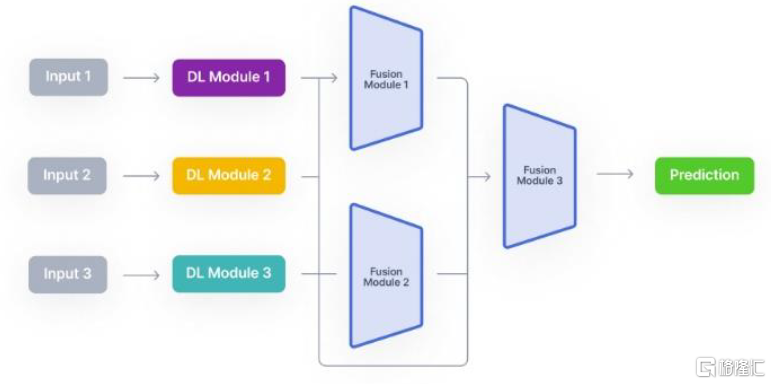

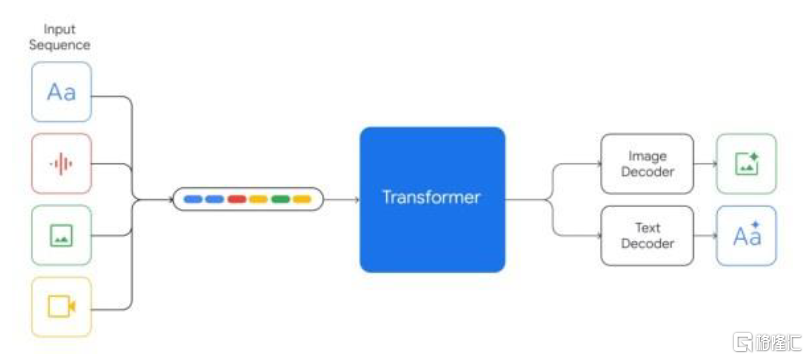

傳統的多模態大模型,往往是不同模態的模型分別訓練後再融合在一起,雖然能夠用一個大模型實現對不同模態數據的處理,但是不同模態之間缺乏協調性。而Gemini和GPT-4o的訓練語料同時包括文本、圖像、音視頻等多種模態數據,所有輸入輸出都是在同一個神經網絡中進行處理。從兩家的demo來看,最終的效果是大模型能夠同時理解多模態信息以及信息之間的關系。我們認爲,谷歌和OpenAI兩大行業領先企業均不約而同开發原生多模態大模型,有望引發行業的效仿熱情,原生多模態或成爲未來發展趨勢。

圖表4:傳統多模態大模型架構

資料來源:V7 Labs,中金公司研究部

圖表5:Gemini原生多模態大模型

資料來源:谷歌官網,中金公司研究部

差異點:Gemini上下文窗口更大,GPT-4o展現了更多的應用場景

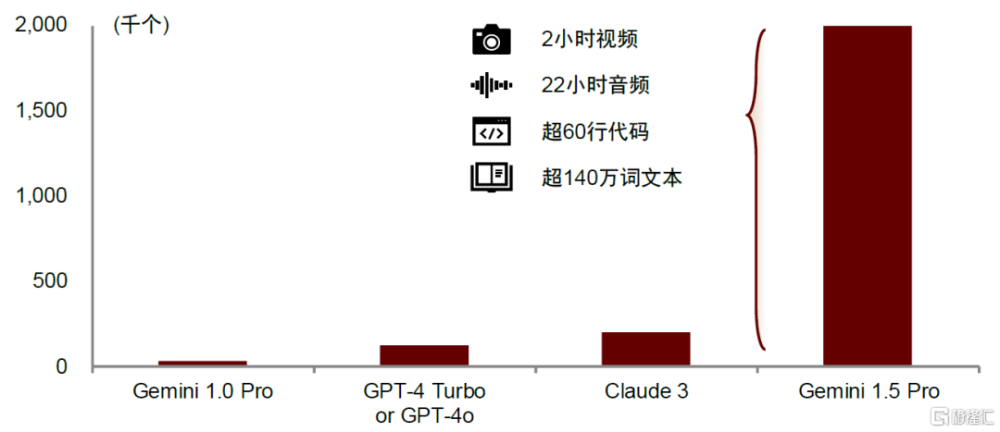

Gemini上下文窗口更大。2024年I/O大會上,谷歌宣布將Gemini 1.5 Pro的上下文窗口token數由100萬個擴容至200萬個,相當於2小時視頻、22小時音頻、超過6萬行代碼或超過140萬詞文本的數據體量,遙遙領先於其他大模型(Claude 3爲20萬個tokens,而GPT-4o僅爲12.8萬個)。

圖表6:Gemini 1.5 Pro、Claude 3、GPT-4 Turbo上下文窗口長度對比

資料來源:谷歌官網,中金公司研究部

Gemini定價更具吸引力。我們以12.8萬個tokens上下文長度爲例,根據谷歌官網信息,Gemini 1.5 Pro輸入、輸出價格分別爲3.5美元/1M tokens、10.5美元/1M tokens,對比GPT-4o(上下文窗口爲12.8萬個tokens)輸入5美元/1M tokens、輸出15美元/1M tokens的定價,Gemini 1.5 Pro的調用成本較GPT-4o下降30%。

圖表7:Gemini 1.5 Pro與GPT-4o的定價

注:GPT-4o上下文tokens長度爲12.8萬個; 資料來源:谷歌官網,OpenAI官網,中金公司研究部

GPT-4o更強調實際應用場景中的人機交互的創新。我們能看到,GPT-4o發布會並未過多展示技術細節,而是將大量時間用於展示GPT-4o如何在手機/PC產品上可能的應用場景,尤其AI語音助手充當了重要角色,在跨模態的人機交互中表現出色。

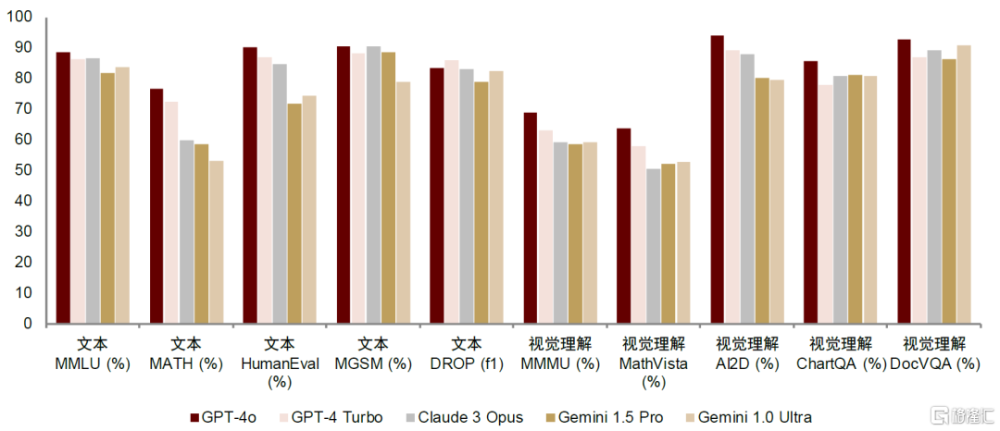

GPT-4o模型性能更勝一籌。根據OpenAI官網測評數據,GPT-4o在文本測試(如MMLU、MATH、HumanEval等)以及視覺理解測試(如MMMU、MathVista等)各類任務中均取得較Gemini 1.5 Pro更優的表現。我們認爲,OpenAI的技術水平仍然領先於行業。

圖表8:主流大模型文本、視覺理解測試性能對比

資料來源:OpenAI官網,中金公司研究部

終端硬件:人機交互方式變革,AI端側落地加速

在AI發展逐漸進入應用變現的下半場後,如何將AI能力賦能給To C端的消費者成爲了重要課題。我們觀察到,除了常規的模型及技術發布外,本次GPT-4o及谷歌發布會均將部分重點放在了展示AI在移動設備,如手機、PC等的實際應用場景。我們認爲,未來AI在端側的應用和消費者觸達變現或將成爲新的發展側重點。

AI+消費電子終端,硬件升級趨勢明確

AI+手機/PC:多模態能力改變人機交互模式

AI手機/PC漸行漸近,AI端側落地前景拓寬。

► 交互方式革新:端到端的多模態能力,使得人機交互方式不再局限於文本,豐富了交互形態,與手機現有應用的協同作用更強。

► AI語音助手擬人化:低時延、能夠隨時打斷、根據即時反饋靈活調整輸出,和豐富的情感色彩,使AI語音助手更加擬人化,改變了過去AI語音助手只能以回合制方式機械回答的冰冷形象。

► AI功能在移動設備的演示,應用場景拓展:谷歌Gemini模型與安卓生態的結合、GPT-4o在iPhone上的演示,讓消費者看到了在手機系統與AI結合的可能,AI調用現有APP甚至跨APP的打通成爲可能,並拓展出更爲豐富的應用場景。

► 商業化前景:除了多元的應用場景外,GPT-4o面向免費用戶开放,考慮手機/PC這類To C市場的龐大用戶群體,AI在端側的廣闊前景受到更多關注。

圖表9:GPT-4o可以改變不同語調回答用戶問題

資料來源:GPT-4o發布會,新智元,中金公司研究部

圖表10:GPT-4o在平板上指導用戶做數學題

資料來源:GPT-4o發布會,中金公司研究部

AI手機:當前小米、三星、谷歌等廠商均陸續推出了自己的AI手機產品。Counterpoint預測,2024年全球AI手機滲透率約8%,出貨量有望超1億部;2027年全球AI手機滲透率約40%,出貨量有望達5.22億部。

圖表11:各品牌最新發布的AI手機

注:統計時間截至2024年5月15日,爲不完全統計 資料來源:各公司官網,中金公司研究部

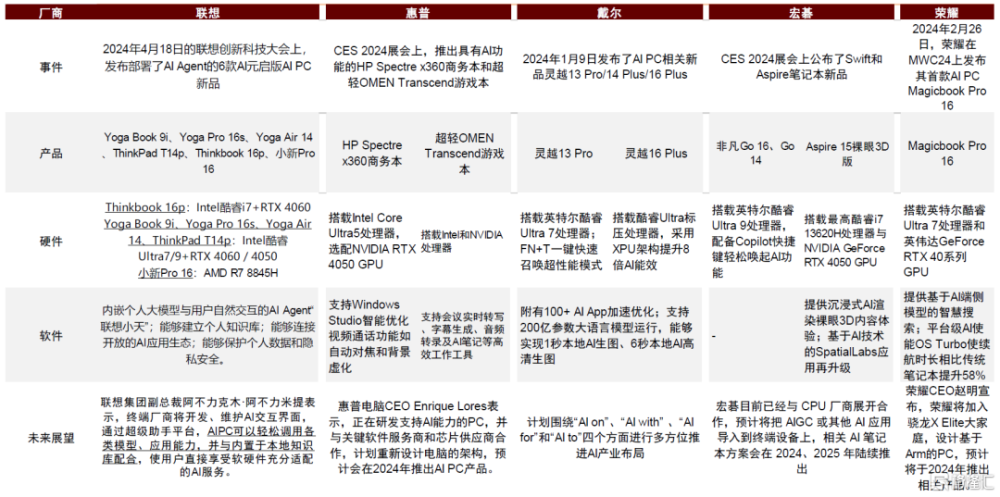

AIPC:AIPC上市或推動PC換機周期到來。考慮到AI在提高生產力、促進應用落地創新的潛在能力,IDC預測,AIPC 有望在2027年滲透率達到85%。

圖表12:各PC廠商對AIPC產品的布局情況

資料來源:聯想官網,惠普官網,戴爾官網,宏碁官網,榮耀官網,中金公司研究部

AI+可穿戴:關注AR空間計算與AI的結合

GPT-4o應用展現空間計算雛形,兼具空間感知及用戶感知。從空間感知層面,GPT-4o展示了初步的識別能力,用戶可以通過攝像頭識別手寫方程,提供解題提示,並逐步引導解題過程,實時提供反饋;同時從用戶感知層面,GPT-4o可以感知用戶的面部、姿態、語音和表情、情緒變化,其理解人類對話中的打斷習慣,能夠適時停下來聽,並給予相應回復,根據用戶語調生成自然、連貫且毫無機械感的對話。我們認爲GPT-4o應用展現了空間計算的雛形,雖然在三維重構、空間感知、用戶感知等領域仍存在一定的提升空間,但新的軟硬結合生態及交互模式正在被逐步構建。

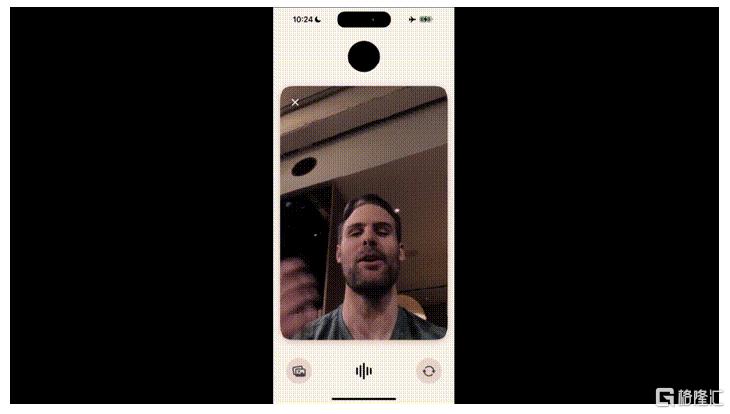

圖表13:GPT-4o在“視頻通話”中感知用戶面部表情

資料來源:OpenAI GPT-4o發布會,中金公司研究部

AI落地端側的優勢在於對周邊感知數據的利用,與空間計算相輔相成,或將引領AR產品走向更多應用場景。我們看到,目前Meta推出的Meta RayBan等AR眼鏡產品已經陸續出現了基於多模態的AI用例。硬件端,芯片廠商同步發力,對AR的重視程度不斷提高,產品定義從手機配件變爲獨立設備。

硬件升級趨勢:關注硬件側變化

我們認爲未來部分算力下沉到端側將成爲必由之路。

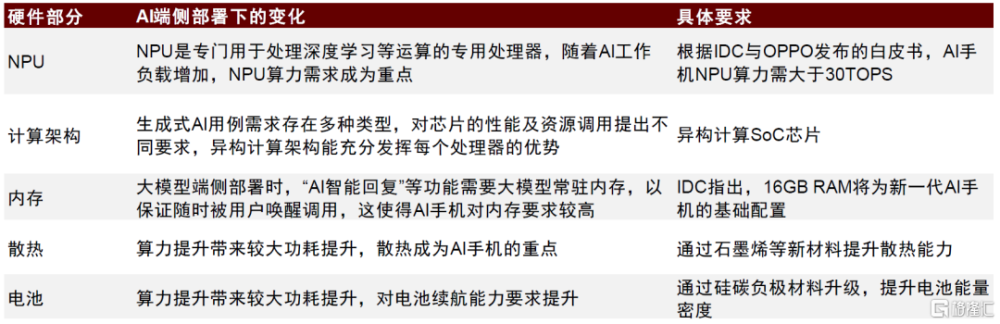

圖表14:AI手機硬件升級趨勢

資料來源:《AI手機白皮書》(IDC及OPPO,2024年),IDC官網,中金公司研究部

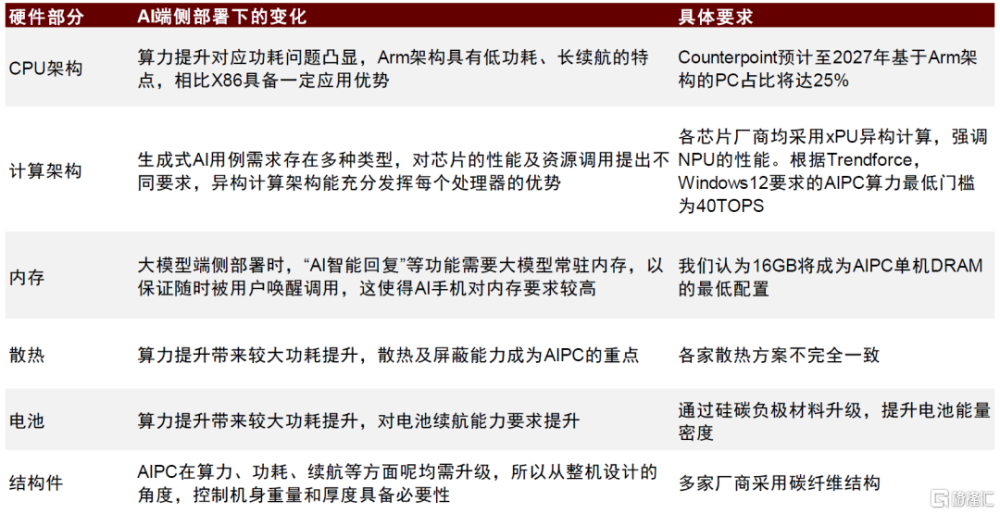

圖表15:AIPC硬件升級趨勢

資料來源:Counterpoint,Trendforce,中金公司研究部

操作系統&應用:AI進入實時互動新紀元,關注操作系統升級及應用前景

人機互動升級,實時交互能力拓展AI應用落地場景

多模態交互能力較大豐富了AI應用的可能場景。此次GPT-4o端到端的交互能力,使得語音、文本、視頻、圖像等不同模態的打通成爲可能,較大豐富了使用的場景。

圖表16:手機App Be My Eyes接入GPT-4o輔助盲人通過攝像頭進行周圍環境搜索並輸出語音

資料來源:OpenAI GPT-4o發布會,中金公司研究部

圖表17:谷歌Gemini “Ask with Video”可實現視頻搜索功能

資料來源:谷歌2024 I/O大會,中金公司研究部

關注蘋果與安卓兩大陣營,底層系統打通將成趨勢

安卓生態:谷歌Gemini放大全生態優勢,有望打通安卓底層系統。更進一步地,我們認爲未來AI與消費者的交互離不开大模型與手機操作系統的深度結合,包括底層操作系統的權限开放、跨APP的內容調用及統一輸出等。在這方面,谷歌基於其在安卓生態的強大影響力,已經开始布局。在本次I/O大會上,谷歌展示了Gemini與谷歌原生產品,尤其是安卓操作系統層面的深度結合。谷歌表示,本地運行的多模態Gemini Nano模型將登陸Pixel手機,Gemini APP將支持語音及視頻實時交互;谷歌將推出自定義AI助手功能Gems,可與“谷歌全家桶”進行交互。展望未來,我們預計谷歌有望憑借自身在安卓生態的強大優勢,加速其在移動設備,尤其是安卓手機領域的AI功能滲透。

圖表18:谷歌2024年I/O大會對安卓系統的升級

資料來源:谷歌2024年I/O大會,中金公司研究部

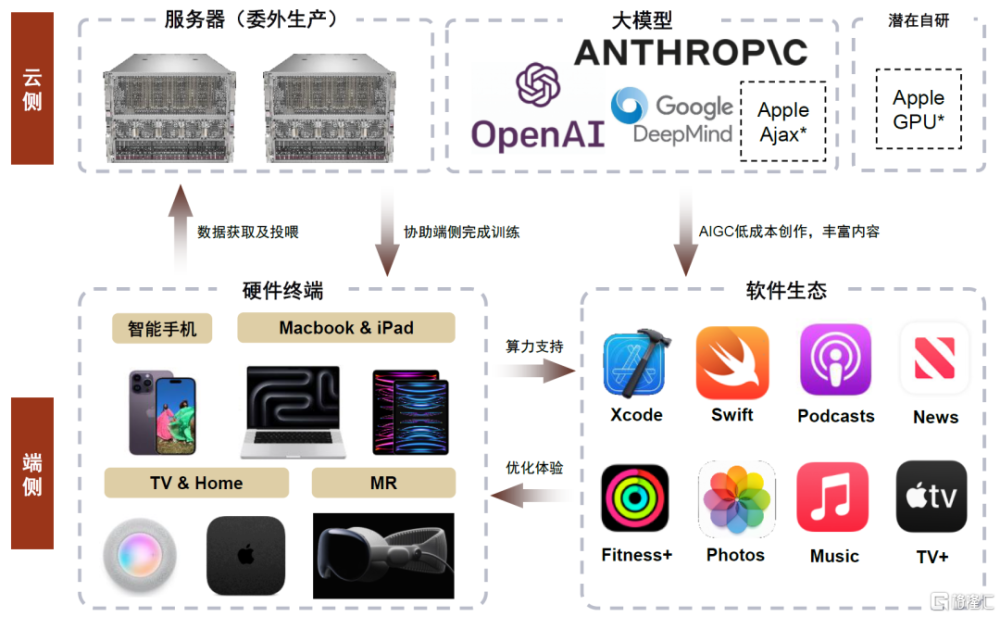

蘋果:端雲協同,優化用戶體驗,推動終端加速智能化發展。本次GPT-4o展示主要以iPhone爲主,同時也有Mac的亮相。除了手機APP端,OpenAI還推出了適用於macOS的桌面級應用。此前有新聞報道[3],蘋果正在與Open AI及谷歌就AI方面合作進行談判。我們認爲蘋果在生成式AI或將通過端雲混合的方式實現,在手機、平板、電腦及MR等端側,蘋果可以通過A+M系列芯片算力支持,完成中小模型訓練,需要時也可向雲端借用算力以完成訓練要求。當前蘋果已積累大量原生App,如Music、TV+、Fitness+及News等,我們認爲蘋果在雲端大模型(如Ajax等)訓練後,結合用戶日常搜索及使用習慣,有望實現個性化用戶推送。考慮蘋果已收購的AI Music等初創公司,我們認爲蘋果有望結合用戶偏好實現定制化內容生成,進一步提高用戶粘性。

圖表19:蘋果AI模式探索(*號表示蘋果暫未正式發布,但未來有布局潛力方向)

資料來源:蘋果官網, OpenAI、Google、Anthropic官網,中金公司研究部

安卓手機廠商:除了大模型廠商外,安卓手機廠商也在加快自身大模型研發。力圖在未來的AI端側時代佔得先機,目前華爲、小米、OPPO、vivo、三星、傳音等廠商均推出了大模型,並結合進自身的操作系統。

語音助手使AI Agent成爲可能,流量入口或將迎來變化

語音助手擬人化程度提升,AI agent成爲可能。此次GPT-4o最令觀衆眼前一亮的在於具有情感色彩、即時進行多模態反饋的AI語音助手能力,同時谷歌發布的Astra亦具有多模態的反饋能力。從移動端AI的發展趨勢看,我們認爲未來手機端AI Agent的發展方向是Agent自主調用手機端應用,讓用戶享受到專屬手機智能助理的服務,從而打破APP的隔閡,通過自主的規劃決策實現跨應用的操作。

圖表20:GPT-4o通過語音助手方式與使用者交互

資料來源:OpenAI GPT-4o發布會,中金公司研究部

交互方式變化或帶來流量入口變化,深刻影響移動互聯網生態格局。我們前述AI Agent的交互模式,對應了或將替代獨立APP與消費者的直接接觸,而是將所有需求集成進入AI Agent中,這種人機交互方式的改變具有深遠意義。我們認爲未來人機交互的模式有望從文本進化到語音等方式,同時人機交互也將呈現多模態結合的特點。同時,語音助手有望成爲用戶獲取信息及進行交互的重要入口,甚至直接幫助用戶進行內容篩選和內容生成。從遠期角度看,當交互出現跨APP調用後,APP以及應用商店的入口功能被削弱,當前移動互聯網生態的商業模式或許將出現變化。

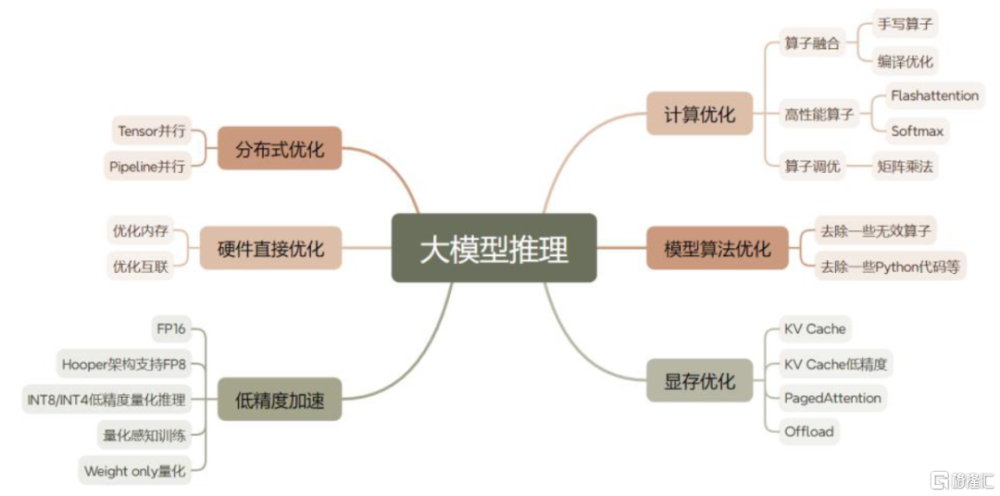

雲端算力硬件:利用率爲上,推理側落地需求推動AI Infra進入大幅優化期

GPT-4o部分功能的免費开放,Gemini能力的提升或對單位算力成本下探提出要求,AI infra面臨大幅優化。我們看到,雖然GPT-4o依舊是GPT-4級別的模型能力,但此次發布大幅度針對端側應用進行了擴充;同時在免費有限次的使用中,交互時延縮短至232 毫秒內,逼近人類反饋。Gemini 1.5 Flash是新推出的模型,重點優化了響應時間,兼顧快速和成本效益。從功能角度看,我們認爲應用能力的推廣以及交互時延的降低均對於雲端算力芯片的推理能力提出了更高的要求。

圖表21:GPT-4o向用戶开放免費使用部分功能

資料來源:OpenAI GPT4o發布會,中金公司研究部

應用加速开發推動算力資源向推理任務傾斜;推理過程預填充階段(Prefill)對單卡算力有較高需求,解碼階段(Decode)內存帶寬是推理性能限制因素。若使算力硬件系統針對推理任務優化,一方面可以直接通過升級硬件性能來解決。另一方面,由於每分每秒的GPU運行均是成本开銷,所以對於實際推理任務中,我們要先去衡量究竟是何種原因導致系統效率瓶頸,並結合具體系統服務能力敏感指標來具體針對性的實施工程優化。實際應用情況中,我們多採用“以計算換存儲”或“以存儲換計算”來提升硬件利用率(算力利用率MFU及訪存利用率MBU),以減小延時,增加吞吐量,提升硬件利用率來降低推理成本。

圖表22:大模型推理優化方式詳解

資料來源:英偉達官網,中金公司研究部

從模型創新到加速應用落地,資本开支結構或將向邊緣推理側傾斜。2023年北美頭部四家雲廠商(亞馬遜、微軟、谷歌、Meta)資本开支合計達到1474.5億美元,結合各家指引,當前彭博一致預期認爲2024年資本开支總值同比增長33%至1966.1億美元,AIGC的發展驅動資本开支總量擡升。而結合此次GPT-4o發布會中,我們看到隨着應用加速部署,AI的發展脈絡逐漸從模型創新、向大模型端側部署傾斜,由此帶來的算力資源變化,或將帶動資本开支結構向邊緣推理側傾斜。

硬件方面的優化

計算芯片推陳出新

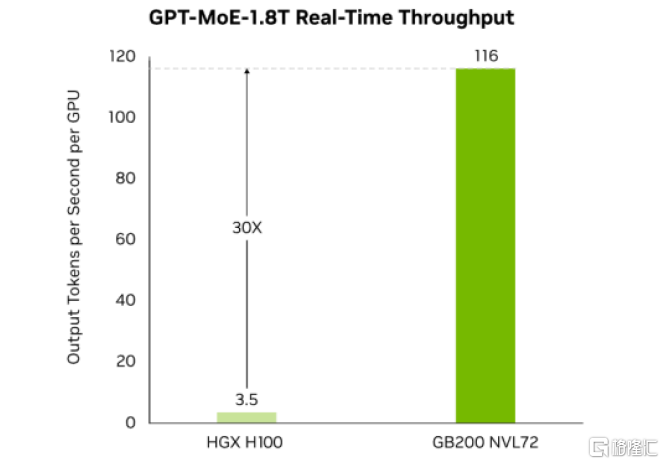

英偉達推出GB200 NVL72,相比H100可爲萬億參數語言模型提供30倍的實時LLM推理性能,有望助力產業探索應用开發。展望未來,我們看好GB200 NVL72憑借集成式的高算力、優異的互聯能力以及大幅度的內存帶寬,在推理任務側持續助力產業界探索應用开發,提供性價比較高的算力解決方案。

圖表23:GB200 NVL72與H100推理速度對比

資料來源:英偉達官網,中金公司研究部

谷歌TPU迭代升級,芯片自研進一步深化。TPU v6 Trillium正式推出,谷歌表示其單片峰值計算性能較TPU v5e提高470%,能效較TPU v5e高出67%以上。從內部設計看,TPU v6擴展了矩陣乘法單元MXU,提高了時鐘速度,將HBM的容量和帶寬提高了一倍、片間互聯的帶寬亦增加了一倍,同時配備了SparseCore專用加速器優化工作負載,最終實現性能與能效的大幅提升。

圖表24:谷歌TPU v6 Trillium

資料來源:谷歌2024年I/O大會,中金公司研究部

網絡硬件持續迭代

我們認爲,由於AI數據中心GPU並行計算需要高頻中間計算結果通信,且通信效率影響整體計算集群性能,所以對通信帶寬、網絡時延、網絡穩定性、自動化部署等提出較高需求。

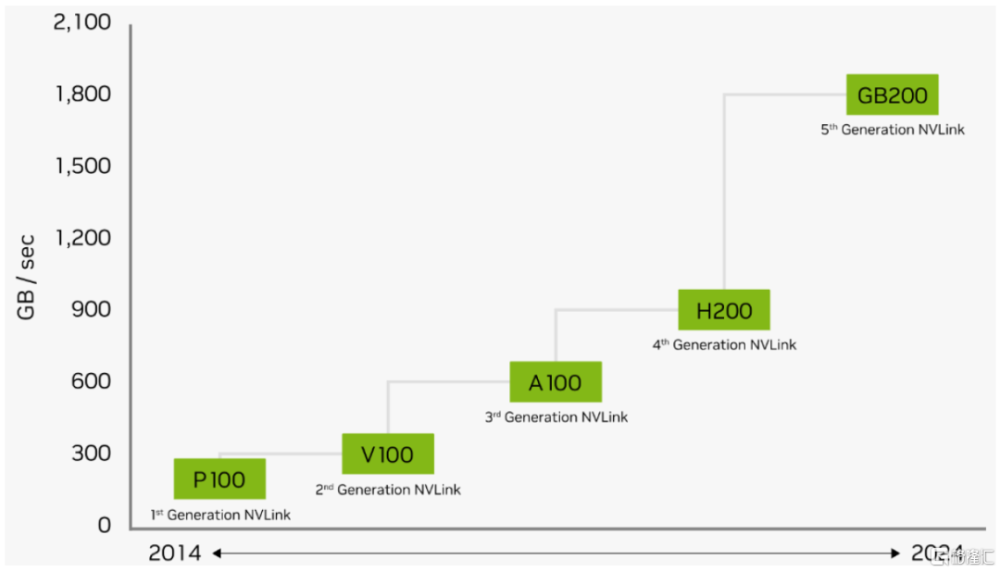

C2C方面,GB200 NVL72利用全互聯的第五代NVLink網絡,單個GB200 Tensor核心GPU最高可支持18個100GB/s的NVLink連接,總雙向帶寬達到1.8TB/s,相比第四代NVLink實現翻倍,相較於2014年初代的160GB/s實現了12倍提升。

圖表25:NVLink雙向帶寬升級至1.8TB/s

資料來源:英偉達官網,中金公司研究部

NVSwitch是NVLink技術的延伸,解決GPU間通訊不均衡問題。新一代NVLink Switch系統最多可連576塊GPU,連接總帶寬最高達1PB/s。

B2B方面,200G SerDes賦能,X800系列交換機帶寬、端口速率同步升級。英偉達X800系列交換機和ConnectX-8網卡代表數據中心內B2B互聯的最高水平。ConnectX-800G智能網卡速率升級至800GB/s,最高支持48通道PCIe 6連接;其兼具通信優化和計算卸載功能,能夠與交換機協同提升B2B傳輸效率。

谷歌液冷數據中心穩步推進。2018年谷歌發布TPU3.0 Pod將液冷技術引入數據中心,至今部署液冷系統的數據中心已達1GW。我們認爲液冷作爲散熱效率更高的方式,憑借提升算力部署密度及降低系統功耗的優勢,有望實現對傳統風冷的替代,未來滲透率有望繼續提升。

系統工程的優化

1)優化顯存:在推理過程中,除了模型在各個層級的權重本身佔用顯存外,KV Cache(即Attention塊中的Key和Value矩陣,推理decode階段減少重復計算所需要緩存的部分)也佔用了較大的顯存。目前大部分針對KV Cache的優化工作,主要集中在工程上。不過近期我們看到針對Attention塊的創新變化也在發生,如DeepSeek在其最新發布的V2版本大模型中引入了MLA機制,獲得了較好的KV Cache降低效果,模型性能也保持了不錯的穩定性。我們看到業界在不斷尋求更優化的方法來降低KV Cache訪存开銷,以此來獲得更大的batch size以獲得更高的硬件利用率。

2)算子融合/算子實現優化:在模型訓練時,工程師一般會選擇小算子反復探求每步驟輸入輸出結果的關系來對模型做優化,而對於推理任務來看,在模型訓練完成後更多會使用大算子來獲得更加的硬件執行效率。在算子實現上(即如何將計算邏輯和芯片架構相結合)也可以發掘相對較頻繁執行的算子,並將其在GPU的物理實現上通過更優化的編譯策略來增大單位時間內GPU利用率。

3)低精度(量化)加速:推理過程中,權重的量化是加速推理重要方法之一。在推理時,我們發現FP16 權重通常能提供與 FP32 相似的精度,這代表着在推理時通過將權重量化爲FP16,僅需一半 GPU 顯存就能獲得相同的結果,甚至採用更低精度如INT8/INT4來量化來獲得更好的效果。我們認爲在一些專用處理器中往往存在一些專門爲整型運算設計的加速單元,可以實現更好的算力利用率及能耗比。

4)分布式推理:雖然與訓練端相比,推理的計算量相差甚遠,但我們在前文中提及,大模型推理中部分場景是訪存受限的(尤其對於模型升級後更長的上下文窗口這類需求)。因此爲提升GPU利用率,工程上會採用張量並行(Tensor Parallelism, TP,爲模型並行的一種,屬於層內並行),將LLM模型參數進行切分,從而減少從顯存中讀取模型參數的耗時。

風險提示

AI算法落地進度不及預期:ChatGPT\GPT-4等模型不开源,同時存在着隱私數據泄露、模型竊取、數據重構、Prompt Injection攻擊等數據安全性問題、回答准確性問題、道德問題,威脅着模型應用的落地。

AI變現模式不確定:雖然AI的出現或將改變數字內容生產關系,但是:1)ToC端,除了GPT-4,其他AI模型的用戶還處於免費體驗的模式,同時以Microsoft 365、New bing等爲代表的應用也仍處於免費體驗的模式,收費模式尚不確定;2)ToB端,目前大量初創企業接入的ChatGPT、GPT-4 API接口收費較低,未來的收費標准和模式也不確定。

消費電子智能終端需求低迷:受整體宏觀經濟、國際地緣政治衝突及半導體周期下行等因素疊加影響,消費電子市場受到較大衝擊,國內外市場需求均呈現不同程度的疲軟。若2024年消費電子需求回暖不及預期,我們認爲硬件端受益AI的進展或將不及預期。

注:本文摘自中金公司2024年5月16日已經發布的《AI浪潮之巔系列:AI端側落地加速,开啓實時互動新紀元》;彭虎、溫晗靜、成喬升、李詩雯、黃天擎、孔楊、查玉潔、李澄寧、石曉彬、賈順鶴、陳昊

標題:中金研究:AI端側落地加速,开啓實時互動新紀元

地址:https://www.iknowplus.com/post/108219.html