AI的下一個引爆點

ChatGPT發布一年後,圍繞生成式AI的熱潮已經席卷科技企業,手機、PC廠商都在爭先將AI融入產品中,由此,也讓新一輪的設備硬件內卷序幕,被快速拉开。

自8月份華爲將盤古大模型接入手機智能助手後,小米、OPPO、ViVo、榮耀均快速跟上隊形,生成式AI儼然是未來幾年新機發布必不可少的一個賣點。

當手機廠商都在搶着落地大模型時,PC也开啓了自己的AI革命。率先提出“Copilot”的微軟已經將Open AI的大模型融入到操作系統,以及生產力工具當中。

生成式AI從雲端加速走向終端的同時,對設備AI處理能力的要求倒逼了硬件架構的加速升級。

在手機端,高通在下半年發布的驍龍8 Gen 3處理器,已經可以支撐運行高達100億參數的大模型。只需0.6秒,就能生成1張不錯的圖片,甚至比國內很多大模型都快又好很多。

在PC端,今天在“AI Everywhere”發布會上,英特爾拿出了代號Meteor Lake的新一代酷睿™Ultra處理器,首次內置了人工智能加速引擎NPU。

與雲端訓練場景截然不同的是,大模型推理階段對算力資源的要求並不是那么苛刻,但要接入更牛的模型,對芯片計算能力,內存帶寬,電池能耗的挑战增加,消費端用戶要充分感受AI帶來的質變,成本和差異化體驗是最大的變量。

這其中,就是各家設備商們可以各項神通的演武場。

他們等這樣一個機會,等了太久。

01交互革命

AI大模型對於智能終端帶來最大的幫助,體現在交互價值上。近幾年終端一直缺少這種顛覆性的變化,所以當Open AI拿出以GPT爲底座的ChatGPT,不少人感覺好像回到了2007年iPhone問世的時刻。

落地終端最清晰的終極愿景,就是AI Agent,看過科幻片的都懂。

對此,聯想CEO楊元慶的定義是,部署在終端設備的大模型使用我們存儲在本地服務器上的個人數據進行推理,接入了大模型的設備仿佛用戶的數字延伸,通過對我們使用設備的模式學習和模仿成爲了我們的智能共同體,他稱爲“AI Twin”。

在AIPC概念出來之前,手機助手也貼着智能的標籤被手機廠商當成賣點,實際上都還只是編程指令式的機械問答,智障助手一樣,純粹在佔用我們的內存空間。

GPT的誕生,才讓人類第一次感受到,原來與智能助手溝通可以這么的絲滑,借助大模型檢索、分析、邏輯推理的能力,我們能夠更自然隨意地和AI助手進行交流,指派更復雜的指令。

首先,時效性決定了很多應用場景的存在意義。端側AI純靠設備處理器提供支撐,在無網或弱網條件下也能正常運行,也就不存在網絡延遲等不良體驗的幹擾。

同時,我們的短信、照片、聊天記錄、備忘錄、日程形成了可供大模型檢索的向量數據庫,無需重新訓練即可結合文本生成能力形成最終輸出,並且這些數據在加工的同時不需要上傳至雲端,保障了隱私安全。

此外,多模態能力可以給用戶帶來豐富的交互體驗。AI大模型在自然語言處理、圖像識別和語音識別等方面的泛化能力在設備端能夠創造更多有想象力的應用場景。

例如VIVO接入藍心大模型的小V,提到手機上萬張的圖片管理中,用戶可以嘗試直接以語義識別的方式說出照片的內容理解,讓小 V 在相冊中主動識別有對應內容的照片。

來源:AI新智界

從廠商的角度,用戶體驗和成本直接影響了設備商對大模型技術的介入程度。

一來,通用大模型的在雲端訓練和推理本就十分耗費資源,不光算力,數據傳輸還要消耗網絡帶寬、存儲等大量資源,光是雲端的算力成本已經讓Open AI這種初創公司感到昂貴,ChatGPT僅維持用戶訪問的一個月成本就達到了1000萬美元。

他們投資的AI硬件公司的第一代產品AI Pin,每月要交24美元的訂閱費才能調用AI功能,這對幾乎從不在手機上訂閱任何服務的用戶來說,要讓他們額外花錢用AI助手,幾乎不可能。

終端手機廠商不敢爲了一個不成熟的技術應用就躬身投入,相比之下,邊緣設備猶如“毛細血管”,替中心節點承接了一部分計算需求,“雲”與“端”的相互配合,或許是大模型加速應用开枝散葉的關鍵。

部分手機廠商如華爲、VIVO、OPPO走的就是“雲”“端”協同的路线,做出從十億到千億等不同參數規模的模型矩陣,結合參數規模和硬件特性,手機或能做出差異化的特色。

在華爲的展示裏,用戶已經可以直接和小藝同學用自然語言交互,溝通自己的需求,而華爲再通過元服務拉起相關的app,滿足用戶需求。

另一邊,小米目前主要做的是端側大模型,最新在手機本地跑通了13 億參數模型,部分效果可以媲美60億參數在雲端運行的結果。

如果最終大模型能以標准化的接口調用設備裏的所有功能,未來每個應用甚至都不需要花心思做界面,AI助手就是人機交互界面,變成了所有應用的入口。屆時,用戶和交互界面的關系,設備商,操作系統开發者和第三方應用的關系都將得到重塑。

02如何給大模型“瘦身”?

行業“老炮兒”亟待抓住多年未見的機遇,據英特爾稱,2028年,AIPC將佔PC市場的80%。

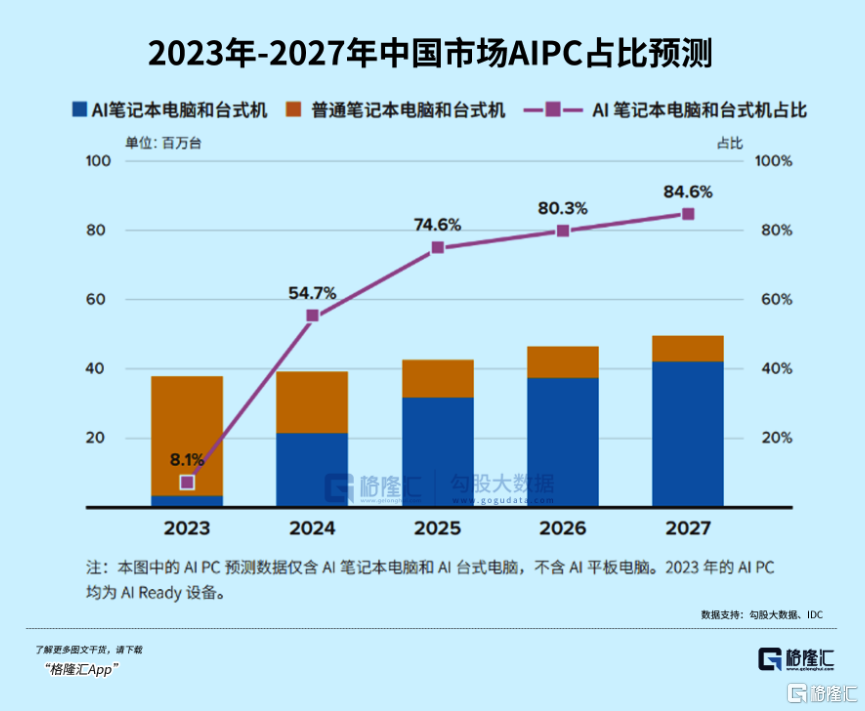

據IDC預測,AIPC(不含平板)在中國PC市場中新機的裝配比例將從今年的8%增長到2027年的85%,對應市場規模將從2023年的141億攀升至2027年的1312億,增長超過8倍。

但有一個前提是,端側要先解決如何將大模型壓縮到適合終端的規模而保證核心能力不流失。

對設備廠商來說,這是一大挑战,但也大機遇。誰能先解決,誰就能率先喫到最豐厚的紅利。

一種解決方法是提升小模型的性能,專注小而美。

比如微軟訓最近練出的Phi-2憑借27億參數,在測試中幾乎打穿了所有130以下的大模型,包括谷歌最新發布的Gemini Nano 2;與25倍體量的Llama-2模型相比,它在多步推理任務(即編碼和數學)上的性能甚至還要更好。

但就AIPC而言,傳統的以CPU爲主的算力架構已經難以滿足AI神經網絡並行運算的要求,英特爾爲此提出“XPU”的方案,即CPU+NPU+GPU。結合NPU高能效低功耗、CPU適合輕量級,單次推理任務,GPU負責並行計算的高吞吐場景等特點,更加靈活地應對不同場景的AI算力需求。

據悉,微軟內置Copilot的PC對算力的要求門檻是40TOPS。高通新款PC處理器驍龍X Elite,整體AI引擎可以提供75TOPS的算力。

而AMD將於2024年推出的Ryzen 8000系列同樣也能達標。

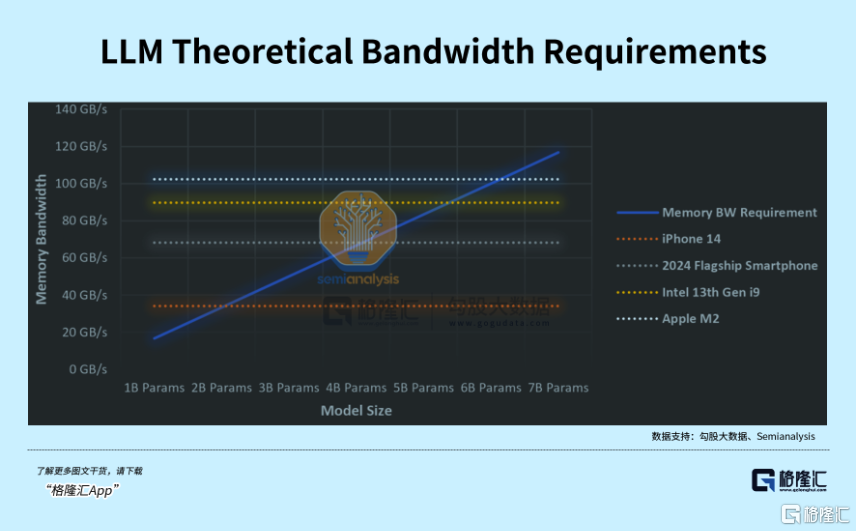

但總體來看,“每個人都能用上AI”的愿景目前來看還是奢侈的,因爲AI功能而擴展的硬件升級要求除了加速處理器,還有高內存帶寬,低功耗。終端能否跑通上百億甚至上千億的大模型,不僅取決於能否跑得動,還取決於內存是否裝得下。

目前大多數電腦的內存容量是8GB,但運行一個70億參數的大語言模型,在16位的精度下至少也需要14GB內存。一種可行的解決方案是通過對模型量化壓縮來減小內存佔用,一個七十億參數的模型如果經過量化,大概能縮至2G-4G的運行內存,這樣手機端才能裝得下。

同時,大多數手機和PC的傳輸速度都在1GB/s以下,最快的PC存儲驅動器最多可達到6GB/s。在1GB/s和4位量化下,也只能運行約20億大小的模型。

不過,從另一面視角來看,這恰恰正是設備商們的時代性的超級機遇。

因爲由AI驅動的換機潮,勢必會出現。

無論是手機,還是PC端,帶來的市場規模將會是無比龐大的。

03PC重生

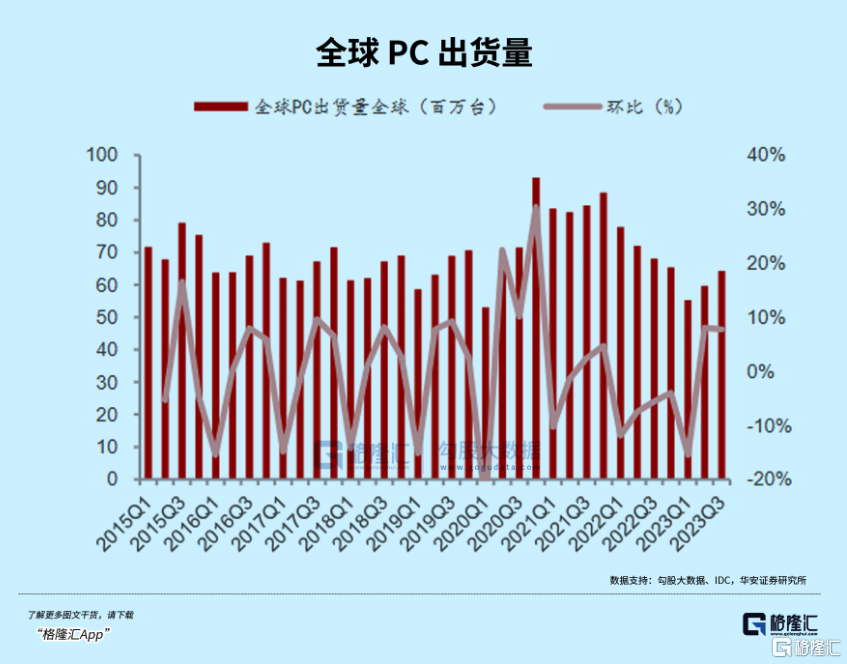

個人電腦、手機先後於2011年,2016年步入存量市場,2020年後由於线上辦公需求增加,透支的需求使得PC出貨量在21年達到3.4億台的峰值,此後需求持續低迷,出貨量驟降,庫存疊加,傳統PC的自然換機周期缺乏技術創新的驅動力。

據IDC,今年前三季度全球PC出貨量同比下降17.1%合計1.87億台,跌到了2005年的水平。

經過兩年的調整,個人PC市場已經處在出貨量和庫存周期的底部,新一輪換機周期也即將恰逢其時。

一方面,三季度的全球PC出貨量環比增長了11%,同比降幅縮窄至7.6%。經歷了一年多的去庫存階段,主流廠商如聯想、惠普、戴爾當前的庫存水位已達到較爲健康的水平,去化接近尾聲。

另一方面,Windows 10即將於2025停更,配置Copilot的新系統或需要更高配置的電腦支撐。根據微軟官網披露信息,Windows 10將於2025年10月14日停更,屆時僅支持Windows 10或更低系統配置的個人電腦將難以適用。

Gartner認爲,個人PC市場已經觸底,庫存隨着教育市場的季節性需求和假日銷售將逐漸恢復正常,預計2024 年全球PC市場將增長4.9%。

目前,英特爾正在與100多家軟件廠商合作,爲PC市場帶來數百款AI增強型應用,這些極具創造力、生產力和趣味性的應用將變革PC體驗。

之前英偉達黃仁勳也說過:“PC行業正迎來一次重生的機遇。在未來10年,新的AI PC將取代傳統PC,市場價值可達上萬億美元。”

大佬們都這么說,也這么开始着手了,如果我們依舊對這個行業莫不關心,或許又將會錯過一個難得的機遇。

標題:AI的下一個引爆點

地址:https://www.iknowplus.com/post/61946.html