英偉達GPU,警鐘敲響

在傳出法國將對英偉達發起反壟斷調查後不久,又有新的不好消息傳出。

據彭博社引述歐盟競爭事務負責人瑪格麗特·維斯塔格 (Margrethe Vestager) 的警告稱,英偉達公司的 AI 芯片供應存在“巨大瓶頸”,但表示監管機構仍在考慮如何解決這個問題。

“我們一直在向他們詢問問題,但這還只是初步問題,”她在新加坡之行中告訴彭博社。到目前爲止,這“還不具備監管行動的條件”。

自從英偉達成爲人工智能支出熱潮的最大受益者以來,監管機構就一直關注着它。它的圖形處理單元(簡稱 GPU)因其能夠處理开發 AI 模型所需的大量信息的能力而受到數據中心運營商的青睞。

芯片已成爲科技界最熱門的商品之一,雲計算提供商相互競爭以獲取這些芯片。據估計,Nvidia 的 H100 處理器需求旺盛,已幫助他們獲得 80% 以上的市場份額,領先於競爭對手英特爾公司和超微半導體公司。

盡管供應緊張,但 Vestager 表示,人工智能芯片供應的二級市場可能有助於激發創新和公平競爭。

但她表示,佔主導地位的公司未來可能會面臨某些行爲限制。

“如果你在市場上擁有這種主導地位,那么有些事情你不能做,而小公司可以做,”她說。“但除此之外,只要你做你的生意並尊重這一點,你就很好。”

6000億美元的“大難題”

盡管高科技巨頭在人工智能基礎設施方面投入了大量資金,但人工智能帶來的收入增長尚未實現,這表明生態系統的最終用戶價值存在巨大差距。事實上, 紅杉資本分析師戴維·卡恩( David Cahn)認爲,人工智能公司每年必須賺取約 6000 億美元才能支付其人工智能基礎設施(例如數據中心)的費用。

去年,Nvidia 的數據中心硬件收入達到 475 億美元(其中大部分硬件是用於 AI 和 HPC 應用的計算 GPU)。AWS、Google、Meta、Microsoft等公司在 2023 年爲 OpenAI 的 ChatGPT 等應用在其 AI 基礎設施上投入了巨額資金。然而,他們能賺回這筆投資嗎?David Cahn 認爲,這可能意味着我們正在目睹金融泡沫的增長。

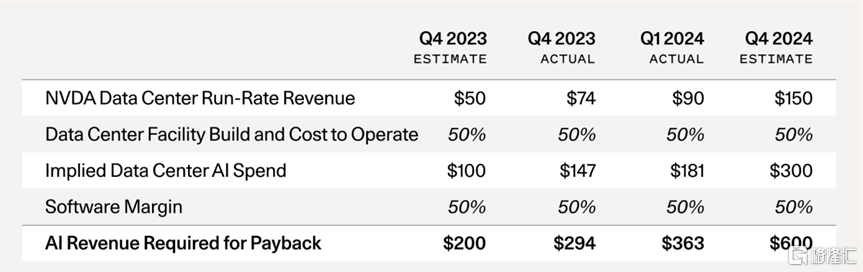

按照David Cahn的算法,6000億美元這個數字,可以通過一些簡單的數學運算來得出。

你所要做的就是將 Nvidia 的運行率收入預測乘以 2 倍,以反映 AI 數據中心的總成本(GPU 佔總擁有成本的一半,另一半包括能源、建築物、備用發電機等)。然後你再乘以 2 倍,以反映 GPU 最終用戶的 50% 毛利率(例如,從 Azure 或 AWS 或 GCP 購买 AI 計算的初創公司或企業,他們也需要賺錢)。

我們看看,自 2023 年 9 月(在當時,他認爲人工智能是2000億美元難題)以來發生了什么變化?

一、供應短缺已經消退: 2023 年末是 GPU 供應短缺的高峰期。初創公司正在給風險投資公司打電話,給任何愿意與他們交談的人打電話,尋求幫助以獲得 GPU。如今,這種擔憂幾乎完全消除了。對於我交談過的大多數人來說,現在以合理的交貨時間獲得 GPU 相對容易。

二、GPU 庫存不斷增長: Nvidia 在第四季度報告稱,其數據中心收入的一半左右來自大型雲提供商。僅微軟一家就可能佔Nvidia 第四季度收入的約 22%。超大規模資本支出正在達到歷史水平。這些投資是大型科技公司 2024 年第一季度收益的主要主題,首席執行官們有效地告訴市場:“無論你喜不喜歡,我們都會投資 GPU。”囤積硬件並不是一個新現象,一旦庫存足夠大以至於需求下降,就會成爲重置的催化劑。

三、OpenAI 仍然佔據着 AI 收入的最大份額: The Information 最近報道稱,OpenAI 的收入現在爲34 億美元,高於 2023 年底的 16 億美元。雖然我們已經看到少數初創公司的收入規模達到不到 1 億美元,但 OpenAI 與其他公司之間的差距仍然很大。除了 ChatGPT,消費者今天真正使用了多少 AI 產品?想想你每月花 15.49 美元從 Netflix 或每月花 11.99 美元從 Spotify 獲得多少價值。從長遠來看,AI 公司需要爲消費者提供巨大的價值,才能繼續掏錢。

四、1250 億美元的缺口現在變成了 5000 億美元的缺口:在最後的分析中,我慷慨地假設谷歌、微軟、蘋果和 Meta 每年都能從新的 AI 相關收入中產生 100 億美元。我還假設甲骨文、字節跳動、阿裏巴巴、騰訊、X 和特斯拉每年都有 50 億美元的新 AI 收入。即使這仍然是正確的,並且我們在名單上再添加幾家公司,1250 億美元的缺口現在也會變成 5000 億美元的缺口。

這還沒完——B100 即將問世: 今年早些時候,Nvidia 宣布推出 B100 芯片,其性能提升了 2.5 倍,而成本僅增加了 25%。我預計這將導致 NVDA 芯片需求的最終激增。與 H100 相比,B100 的成本與性能相比有了顯著的改善,而且由於每個人都想在今年晚些時候买到 B100,因此很可能再次出現供應短缺。

在之前提出關於GPU的問題時,David Cahn收到的最主要反駁之一是“GPU 資本支出就像修建鐵路”,最終火車會开過來,目的地也會到來——新的農業出口、遊樂園、購物中心等。

David Cahn表示,其實他也同意這一點,但他認爲這個論調忽略了幾點:

一、缺乏定價權:在物理基礎設施建設的情況下,您正在建設的基礎設施具有一些內在價值。如果您擁有舊金山和洛杉磯之間的軌道,那么您可能擁有某種壟斷定價權,因爲 A 地和 B 地之間只能鋪設這么多軌道。在 GPU 數據中心的情況下,定價權要小得多。GPU 計算正日益成爲一種按小時計量的商品。與成爲寡頭壟斷的 CPU 雲不同,構建專用 AI 雲的新進入者繼續湧入市場。在沒有壟斷或寡頭壟斷的情況下,高固定成本 + 低邊際成本的企業幾乎總是會看到價格競爭到邊際成本(例如航空公司)。

二、投資浪費:即使是鐵路行業,以及許多新技術行業,投機性投資狂潮也常常導致高額的資本浪費。《The Engines that Moves Markets 》是一本關於技術投資的最佳教科書,其主要觀點(確實,重點關注鐵路行業)是,許多人在投機性技術浪潮中損失慘重。挑選贏家很難,但挑選輸家(就鐵路行業而言,運河)要容易得多。

三、折舊:從技術發展史中我們得知,半導體趨於越來越好。Nvidia 將繼續生產更好的下一代芯片,如 B100。這將導致上一代芯片的折舊速度加快。由於市場低估了 B100 和下一代芯片的改進速度,因此它高估了今天購买的 H100 在 3-4 年後的價值。同樣,物理基礎設施不存在這種相似性,它不遵循任何“摩爾定律”類型的曲线,因此成本與性能的關系不斷改善。

四、贏家與輸家:我認爲我們需要仔細研究贏家和輸家——在基礎設施建設過剩的時期,總會有贏家。人工智能很可能是下一波變革性技術浪潮,GPU 計算價格的下降實際上也有利於長期創新,也有利於初創企業。如果David Cahn的預測成真,它將主要對投資者造成傷害。創始人和公司建設者將繼續在人工智能領域發展——他們將更有可能取得成功,因爲他們將受益於較低的成本和在這一試驗期間積累的經驗。

五、人工智能將創造巨大的經濟價值。專注於爲最終用戶提供價值的公司創建者將獲得豐厚的回報。我們正在經歷一場可能定義一代人的技術浪潮。像 Nvidia 這樣的公司在推動這一轉變方面發揮了重要作用,值得稱贊,並且很可能在未來很長一段時間內在生態系統中發揮關鍵作用。

不過David Cahn也重申,投機狂潮是技術的一部分,所以沒什么好害怕的。那些在這一刻保持頭腦清醒的人有機會創建極其重要的公司。但我們必須確保不要相信現在已經從硅谷蔓延到全國乃至全世界的妄想。這種妄想認爲我們都會快速致富,因爲 AGI 明天就會到來,我們都需要儲存唯一有價值的資源,那就是 GPU。

“事實上,前面的道路將是漫長的。它會有起有落。但幾乎可以肯定,它是值得的。”David Cahn強調。

潛在的挑战者

雖然這是一個談了很多次,但似乎也有了結果的論調。如Futurum Group 首席執行官丹尼爾·紐曼所說,“目前,世界上沒有英偉達的天敵。”

原因如下:Nvidia 的圖形處理單元 (GPU) 最初於 1999 年爲 PC 視頻遊戲中的超快 3D 圖形而創建,後來被證明非常適合訓練大規模生成式 AI 模型,來自 OpenAI、Google、Meta、Anthropic 和 Cohere 等公司推動的模型的規模越來越大,進而需要使用大量 AI 芯片來做訓練。多年來,Nvidia 的 GPU 一直被認爲是最強大的,也是最搶手的。

這些成本當然不菲:訓練頂級生成式 AI 模型需要數萬個最高端的 GPU,每個 GPU 的價格爲 3 萬至 4 萬美元。例如,埃隆·馬斯克 (Elon Musk)最近表示,他的公司 xAI 的 Grok 3 模型需要在 10 萬個 Nvidia 頂級 GPU 上進行訓練才能成爲“特別的東西”,這將爲 Nvidia 帶來超過 30 億美元的芯片收入。

然而,Nvidia 的成功不僅僅是芯片的產物,還有讓芯片變得易於使用的軟件。Nvidia 的軟件生態系統已經成爲大量專注於 AI 的开發人員的首選,他們幾乎沒有動力去轉換。在上周的年度股東大會上,Nvidia 首席執行官黃仁勳稱該公司的軟件平台 CUDA(計算統一設備架構)是一個“良性循環”。隨着用戶的增多,Nvidia 有能力投入更多資金升級該生態系統,從而吸引更多用戶。

相比之下,Nvidia 的半導體競爭對手AMD控制着全球 GPU 市場約 12% 的份額,該公司確實擁有具有競爭力的 GPU,並且正在改進其軟件,紐曼說。但是,雖然它可以爲不想被 Nvidia 束縛的公司提供另一種選擇,但它沒有現有的开發者用戶群,這些开發者認爲 CUDA 易於使用。

此外,雖然亞馬遜的 AWS、微軟Azure 和谷歌雲等大型雲服務提供商都生產自己的專有芯片,但他們並不打算取代 Nvidia。相反,他們希望有多種 AI 芯片可供選擇,以優化自己的數據中心基礎設施,降低價格,並向最廣泛的潛在客戶群銷售他們的雲服務。

J. Gold Associates 分析師傑克·戈爾德 (Jack Gold) 解釋說:“Nvidia 擁有早期發展勢頭,當你建立一個快速增長的市場時,其他人很難趕上。”他表示 Nvidia 在創建其他人所沒有的獨特生態系統方面做得很好。

Wedbush 股票研究高級副總裁 Matt Bryson 補充說,要取代 Nvidia 用於訓練大規模 AI 模型的芯片將特別困難,他解釋說,目前計算能力的大部分支出都流向了這一領域。“我認爲這種動態在未來一段時間內不會發生變化,”他說。

然而,越來越多的人工智能芯片初創公司,包括 Cerebras、SambaNova、Groq 以及最新的 Etched和 Axelera ,都看到了從英偉達人工智能芯片業務中分一杯羹的機會。他們專注於滿足人工智能公司的特殊需求,尤其是所謂的“推理”,即通過已經訓練過的人工智能模型運行數據,讓模型輸出信息(例如,ChatGPT 的每個答案都需要推理)。

例如,就在上周,Etched籌集了1.2 億美元,用於开發一種專門用於運行 transformer 模型的專用芯片Sohu,Transformer 模型是 OpenAI 的 ChatGPT、谷歌的 Gemini 和 Anthropic 的 Claude 使用的一種 AI 模型架構。據介紹,該芯片將由台積電採用其 4nm 工藝生產,該公司表示還已從“頂級供應商”那裏獲得高帶寬內存和服務器供應,但沒有透露這些公司的名字。Etched 還聲稱,Sohu 的速度比 Nvidia 即將推出的 Blackwell GPU“快一個數量級,而且更便宜”,八芯片 Sohu 服務器每秒可處理超過 500,000 個 Llama 70B token。該公司通過推斷已發布的 Nvidia H100 服務器 MLperf 基准測試數據做出了這一判斷,該基准測試顯示,八 GPU 服務器每秒可處理 23,000 個 Llama 70B token。Etched 首席執行官 Uberti在接受採訪時表示,一台Sohu服務器將取代 160 塊 H100 GPU。

荷蘭初創公司 Axelera AI 正在开發用於人工智能應用的芯片,該公司上周宣稱也已獲得6800萬美元美元融資,該公司正在籌集資金以支持其雄心勃勃的增長計劃。這家總部位於埃因霍溫的公司旨在成爲歐洲版的 Nvidia,提供據稱比競爭對手節能 10 倍、價格便宜 5 倍的 AI 芯片。Axelera 創新的核心是 Thetis Core 芯片,它在一個周期內可以執行驚人的 260,000 次計算,而普通計算機只能執行 16 次或 32 次計算。這種能力使其非常適合 AI 神經網絡計算,主要是矢量矩陣乘法。他們的芯片提供了高性能和可用性,而成本僅爲現有市場解決方案的一小部分。這可以使 AI 普及,讓更廣泛的應用程序和用戶能夠使用它。

與此同時,據報道,專注於以閃電般的速度運行模型的 Groq 正在以25 億美元的估值籌集新資金,而 Cerebras據稱在發布其最新芯片僅幾個月後就祕密提交了首次公开募股申請,該公司聲稱該芯片可以訓練比 GPT-4 或 Gemini 大 10 倍的 AI 模型。

所有這些初創公司一开始都可能專注於一個小市場,比如爲某些任務提供更高效、更快或更便宜的芯片。他們也可能更專注於特定行業的專用芯片或個人電腦和智能手機等人工智能設備。“最好的策略是开拓一個小衆市場,而不是試圖徵服世界,而這正是他們大多數人正在嘗試做的,”Tirias Research 首席分析師 Jim McGregor 說。

因此,也許更切題的問題是:這些初創公司與雲提供商以及 AMD 和英特爾等半導體巨頭一起能夠佔領多少市場份額?這還有待觀察,尤其是因爲運行 AI 模型或推理的芯片市場仍然很新。

標題:英偉達GPU,警鐘敲響

地址:https://www.iknowplus.com/post/124026.html