大科技燃爆全場!英偉達發布最強AI加速卡,性能暴漲 30 倍

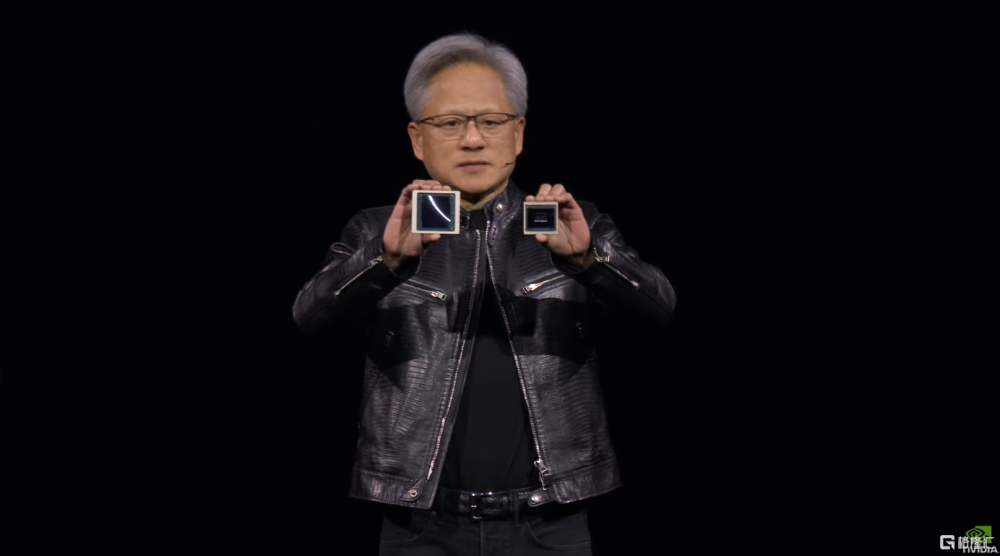

北京時間3月19日4時-6時,英偉達創始人黃仁勳在美國加州聖何塞SAP中心登台,發表GTC 2024的主題演講《見證AI的變革時刻》。

作爲英偉達 2024 的开年大戲,在這場兩個小時的演講中,黃仁勳介紹了運行AI模型的新一代芯片和軟件。英偉達正式推出名爲Blackwell的新一代AI圖形處理器(GPU),預計將在今年晚些時候發貨。

最強AI芯片Blackwell來了!

在本屆 GTC 大會开始之前,國外媒體就已經开始盛傳:黃仁勳將在 GTC 2024 上發布一款 GPU 家族的新品,果然,採用 Blackwell 架構的 B200 和 GB200 系列芯片如期而至。

據英偉達稱,Blackwell 架構系列芯片是迄今爲止功能最強大的 AI 芯片家族。

據介紹,B200 擁有 2080 億個晶體管(而 H100/H200 上有 800 億個晶體管),採用台積電 4NP 工藝制程,可以支持多達 10 萬億個參數的 AI 模型,而 OpenAI 的 GPT-3 由 1750 億個參數組成。它還通過單個 GPU 提供 20 petaflops 的 AI 性能——單個 H100 最多可提供 4 petaflops 的 AI 計算。

但值得注意的是,Blackwell B200 並不是傳統意義上的單一 GPU。它由兩個緊密耦合的芯片組成,這兩個芯片通過 10 TB/s NV-HBI(Nvidia 高帶寬接口)連接進行連接,以確保它們能夠作爲單個完全一致的芯片正常運行。

Blackwell 將被整合到英偉達的 GB200 Grace Blackwell 超級芯片中,該芯片將兩個 B200 Blackwell GPU 連接到一個 Grace CPU。具體來看:

Blackwell擁有六項革命性技術

英偉達稱,Blackwell擁有六項革命性的技術,可以支持多達10萬億參數的模型進行AI訓練和實時LLM推理:

全球最強大的芯片:Blackwell 架構 GPU由 2080 億個晶體管組成,採用量身定制的台積電4納米(nm)工藝制造,兩個reticle極限GPU裸片將10 TB/秒的芯片到芯片鏈路連接成單個統一的GPU 。

第二代 Transformer引擎:結合了Blackwell Tensor Core技術和TensorRT-LLM和 NeMo Megatron 框架中的 英偉達先進動態範圍管理算法,Blackwell 將通過新的4位浮點AI 支持雙倍的計算和模型大小推理能力。

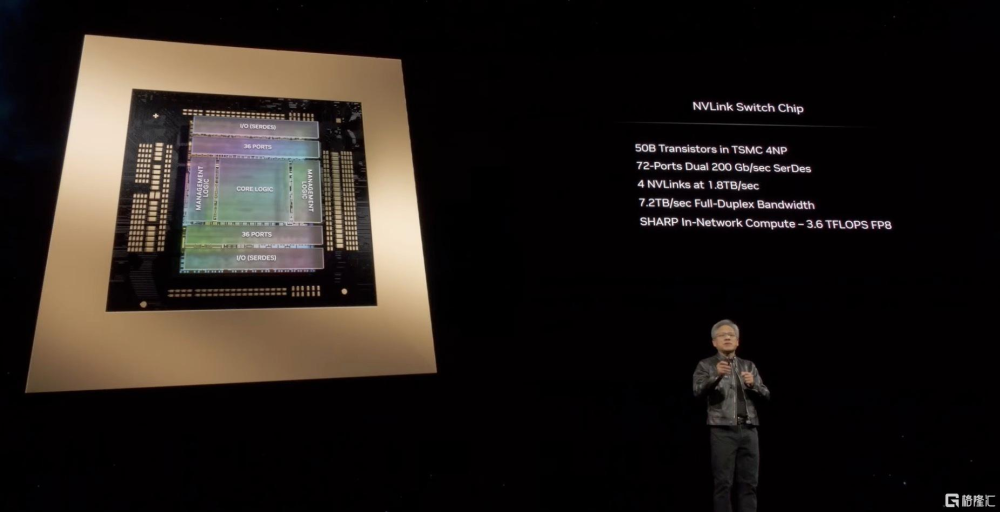

第五代 NVLink:爲提高數萬億參數和混合專家AI 模型的性能,最新一代英偉達NVLink爲每個 GPU 提供了突破性的 1.8TB/s 雙向吞吐量,確保最復雜LLM之間多達576 個GPU 之間的無縫高速通信。

RAS 引擎 :Blackwell 支持的 GPU 包含一個專用引擎,實現可靠性、可用性和服務性。 此外,Blackwell 架構還增加了芯片級功能,利用基於AI的預防性維護進行診斷和預測可靠性問題。

安全人工智能:先進的機密計算功能可在不影響性能的情況下保護AI模型和客戶數據,並支持新的本機接口加密協議,這對於醫療保健和金融服務等隱私敏感行業至關重要。

解壓縮引擎:專用解壓縮引擎支持最新格式,加快數據庫查詢,提供數據分析和數據科學的最高性能。 未來幾年,在企業每年花費數百億美元的數據處理方面,將越來越多地由 GPU 加速。

據英偉達高管表示,該公司正逐步從純粹的芯片供應商轉變爲平台提供商,類似微軟或蘋果。Blackwell不僅僅是一個芯片的名稱,更是一個全新的平台,爲其他公司提供了开發軟件的廣闊天地。

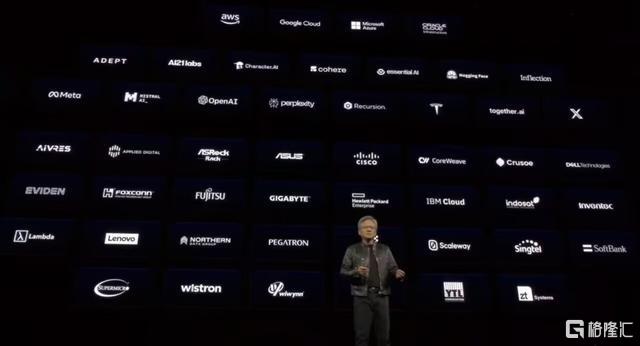

新芯片預計將於今年晚些時候上市。英偉達表示,AWS、戴爾科技、谷歌、Meta、微軟、OpenAI 和特斯拉計劃使用 Blackwell GPU。

亞馬遜、谷歌、微軟和甲骨文將通過雲服務提供對GB200的訪問。GB200將兩個B200 Blackwell GPU與一個基於Arm的Grace CPU配對。英偉達表示,亞馬遜網絡服務將構建一個包含20000個GB200芯片的服務器集群。

英偉達沒有提供新款GB200或其使用系統的成本。據分析師估計,英偉達基於Hopper的H100芯片成本在2.5萬至4萬美元之間,而整個系統的成本高達20萬美元。

英偉達還發布了 GB200 NVL72 液冷機架系統,其中包含 36 顆 GB200 Grace Blackwell 超級芯片,擁有 1440 petaflops(又名 1.4 exaflops)的推理能力,它內部有近兩英裏長的電纜,共有 5000 根單獨的電纜。

英偉達表示,與用於推理用途的相同數量的 H100 Tensor Core 圖形處理單元相比,GB200 NVL72 性能提升高達 30 倍。此外,該系統還可將成本和能耗降低多達 25 倍。

推理微服務NIM

英偉達的NIM軟件也引起了業界的廣泛關注。

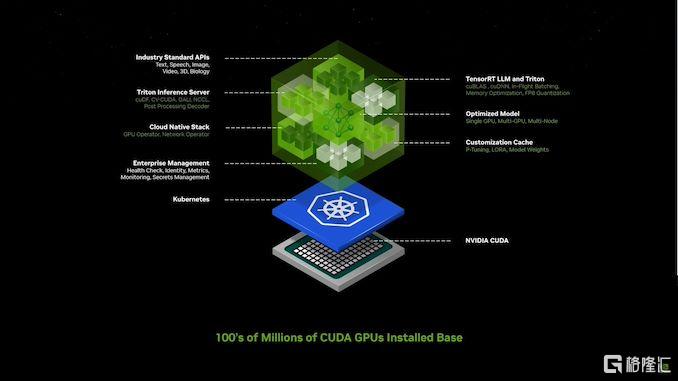

黃仁勳在GTC宣布,將在其企業軟件訂閱中增加一款名爲NIM的新產品。NIM可以更容易地使用舊的英偉達GPU進行推理,並允許公司繼續使用他們已經擁有的數億個英偉達GPU。 推理所需的算例比最初訓練新的AI模型的少。 NIM 讓企業能運行自己的AI 模型,而不是從OpenAI 等公司購买AI的成果。

該產品將使新人工智能模型的初始訓練推理所需的算力更少。該公司的策略是讓購买英偉達服務器的客戶注冊英偉達企業版,每個GPU每年收取費用4500美元。

黃仁勳表示,該軟件還將幫助在配備GPU的筆記本電腦上運行人工智能,而不是在雲服務器上運行。

英偉達將與微軟或Hugging Face等AI公司合作,確保他們的AI模型能夠在所有兼容的英偉達芯片上運行。隨後,开發者可以使用NIM在自有服務器或基於雲端的英偉達服務器上高效運行模型,無需繁瑣的配置過程。

此外,英偉達希望通過發布另一個新的 API 集合 Project GROOT 來推動人形機器人的开發。

Project GROOT 是一個人形機器人模型,英偉達與 Jetson Thor 一起生產,Jetson Thor 是一款 SoC,也是 Nvidia Isaac 的升級版。英偉達表示,GROOT 機器人將理解自然語言並模仿人類動作來學習靈活性。Jetson Thor 運行基於 Blackwell 的 GPU,可在 8 位數據處理中提供 800 teraflops 的 AI 性能。

黃仁勳透露,由該平台驅動的機器人將被設計爲能夠理解自然語言並模仿機器人的動作,觀察人類行爲。這使 GROOT 機器人能夠快速學習協調性、靈活性和其他技能,以導航、適應現實世界並與之互動——並且絕對不會導致機器人叛亂。

標題:大科技燃爆全場!英偉達發布最強AI加速卡,性能暴漲 30 倍

地址:https://www.iknowplus.com/post/91195.html